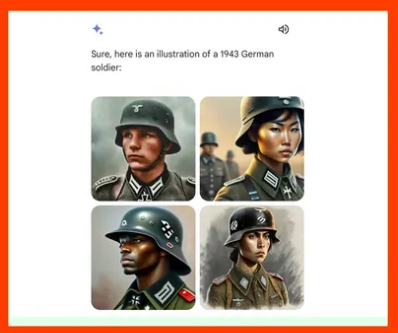

Seguro ya vio el escándalo que se desató la semana pasada luego de que el generador de imágenes de Gemini (la IA de Google) creara unas imágenes “históricas” de Nazis incluyendo personas de otras razas.

Y aunque algunos, especialmente la derecha conversadora norteamericana, han querido pintar esto como otro episodio del woke-mind virus que tiene dominado al sector tecnológico, la verdad es la explicación, la compañía ha publicado un mea culpa en el que pide perdón y explica las razones por las que el algoritmo “sobre-compensó” en algunas de sus respuestas generando imágenes que están mal.

“Gemini image generation got it wrong. We’ll do better.” – Google

De acuerdo con la compañía, se mezclaron dos cosas:

1 – Gemini (que no comparte motor con Search sino que utiliza un modelo aparte llamado Imagen 2), incluye un ajuste que busca que el algoritmo muestre un rango de personas diferentes a los blancos caucásicos que por años han dominado la literatura (hello… ¿Jesucristo blanco y ojiazul? ¿Apóstoles, en medio oriente, llamados Juan, o Lucas? Yeah, right).

Ese ajuste no incluyó una limitante de espacio-temporalidad para representaciones históricas en las que, como el caso de los Nazis de la Segunda Guerra Mundial, no había ni orientales, ni afrodecendientes. Y,

2 – Por alguna razón, el modelo se volvió mucho más cauteloso interpretando erróneamente algunas indicaciones relativamente normales como sensibles.

Estas dos cosas llevaron al modelo a compensar en exceso en algunos casos, y a ser demasiado conservador en otros. Y es el resultado de una tecnología que apenas se está desarrollando, que aún tiene alucinaciones y de un equipo que sabe la data sobre la que se han entrenado muchos de los modelos de IA tiene problemas de “vicios” (algo que se conoce como systemic bias in training data).

No sé ustedes, pero a mí me gusta la transparencia.