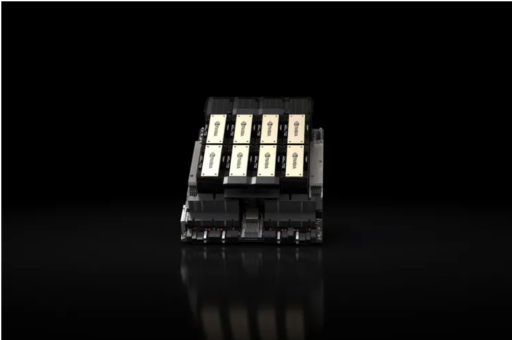

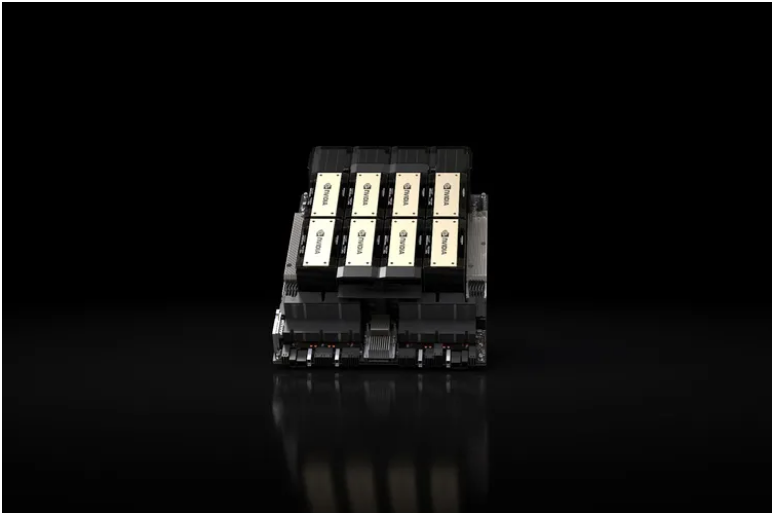

Nvidia presenta un nuevo chip de primera línea para trabajos de Inteligencia Artificial (IA), el “HGX H200”. La nueva GPU actualiza el muy demandado H100 con 1,4 veces más ancho de banda de memoria y 1,8 veces más capacidad de memoria, optimizando su capacidad para manejar trabajos intensivos de IA generativa.

La gran pregunta es si las empresas podrán conseguir fácilmente los nuevos chips o si tendrán una oferta tan limitada como el H100 y, al parecer, Nvidia no tiene una respuesta para eso. Según se informa, los primeros chips H200 se lanzarán en el segundo trimestre de 2024 y ha comentado que está trabajando con “fabricantes de sistemas globales y proveedores de servicios en la nube” para que estén disponibles.

El H200 cuenta con actualización significativa

Hasta donde se conoce, el H200 parece ser sustancialmente igual que el H100 fuera de su memoria. Pero, los cambios en su memoria suponen una actualización realmente significativa. La nueva GPU es la primera en usar una nueva especificación de memoria más rápida llamada “HBM3e”. Esto consigue elevar el ancho de banda de la memoria de la GPU a 4,8 terabytes por segundo, frente a los 3,35 terabytes por segundo del H100, y así mismo, su capacidad total de memoria a 141 GB frente a los 80 GB de su predecesor.

Ian Buck, vicepresidente de productos informáticos de alto rendimiento de Nvidia, dijo en una presentación en video recientemente, “La integración de una memoria HBM más rápida y extensa sirve para acelerar el rendimiento en tareas computacionalmente exigentes, incluidos modelos generativos de IA y aplicaciones [de computación de alto rendimiento], al tiempo que optimiza la utilización y la eficiencia de la GPU”.

Así mismo, hay que mencionar que el H200 también está diseñado para ser compatible con los mismos sistemas que ya admiten los H100. Nvidia ha mencionado que los proveedores de nube no necesitarán hacer ningún cambio a medida que agreguen H200 a la mezcla. Segmentos de la nube de Amazon, Google, así como de Microsoft y Oracle se encontrarán entre las primeras en ofrecer las nuevas GPU el próximo año.

Una vez que se lancen, los nuevos chips seguramente serán costosos. Y es que aunque Nvidia no ha indicado cuánto cuestan, CNBC informa que se estima que los H100 de la generación anterior se venden entre $ 25,000 y $ 40,000 cada uno, y se necesitan miles de ellos para poder operar a los niveles más altos. La portavoz de Nvidia, Kristin Uchiyama indicó que los precios los fijan los socios de Nvidia.