Wow. Tremenda controversia se armó con el anuncio de la expansión de protecciones para niños anunciada por Apple el jueves pasado.

Expertos en seguridad y privacidad, criptógrafos, investigadores, profesores, expertos legales, ejecutivos de otras compañías de tecnología y hasta algunos consumidores de Apple se pronunciaron en contra de las nuevas medidas por medio de una carta abierta dirigida a la compañía.

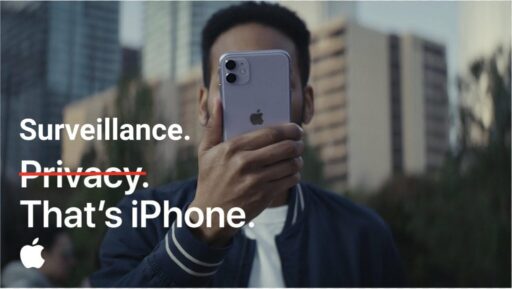

Hasta el propio Edward Snowden y el Electronic Frontier Foundation expresaron su preocupación por lo que el primero denominó un “sistema de vigilancia masiva” que abre una puerta sin precedentes para el futuro (vale la pena leer los 2 hilos) y el segundo alertó “crea un precedente para la creación de puertas traseras” que luego podrán ser usadas para otros fines:

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

— Edward Snowden (@Snowden) August 6, 2021

Apple’s filtering of iMessage and iCloud is not a slippery slope to backdoors that suppress speech and make our communications less secure. We’re already there: this is a fully-built system just waiting for external pressure to make the slightest change. https://t.co/f2nv062t2n

— EFF (@EFF) August 5, 2021

En muchos aspectos, quienes pusieron el grito en cielo tienen razones válidas y más viniendo de una compañía que por años se ha ufanado de ser el paladín de la privacidad; privacidad que algunos ven vulnerada con los nuevos anuncios.

Pero gran parte del problema es que el anuncio es bien técnico, complejo de entender y, como la mayoría de aquellas cosas relacionadas con la compañía, super noticioso. Así que arranquemos por lo primero y entendamos las nuevas medidas anunciadas por Apple

1 – Mejoras en iMessage

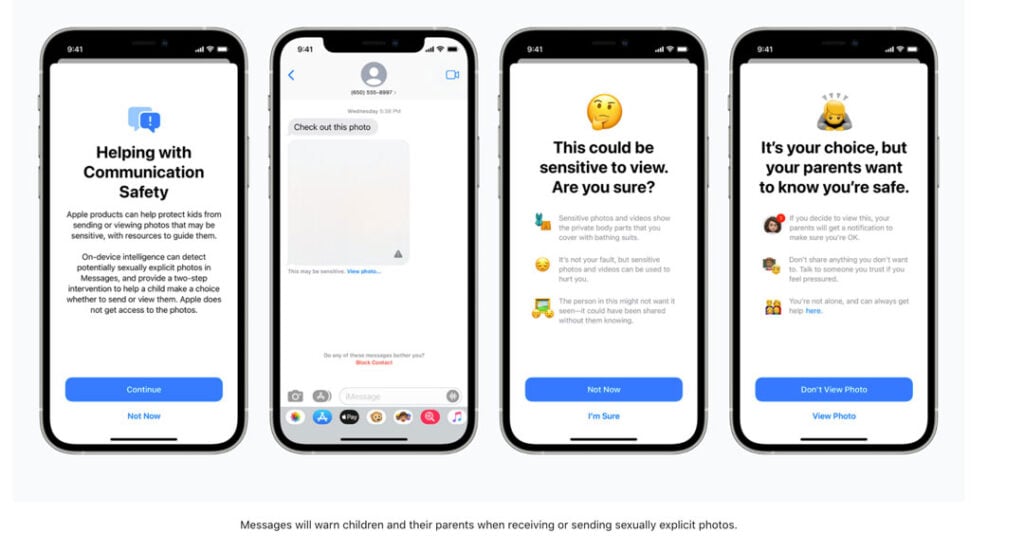

iMessage utilizará algoritmos de machine learning para tratar de detectar cuando los niños reciben o envían material sexualmente explícito.

Temas importantes: 1) Esto sólo aplica para iPhones de niños menores de edad en Estados Unidos, cuyas cuentas sean administradas por sus padres a través de Compartir En Familia de Apple. 2) No cubre los dispositivos de niños que no estén configurados con esa herramienta, ni los mensajes que manden o reciban vía otras apps (como WhatsApp), ni los equipos de gente por fuera de la Unión Americana. 3) Además esto no genera ningún reporte ni a Apple ni a ninguna autoridad. Y 4) es una funcionalidad Opt-in, es decir que los padres deben configurarla.

Si ha sido activada y el algoritmo detecta que una imagen que se está enviando o recibiendo (ojo, puede ser una imagen que venga vía MMS de un dispositivo Android) puede tener material sexual explícito le preguntará al usuario si está seguro que lo quiere ver o enviar y le pedirá una segunda verificación. Si el usuario es menor de trece años le avisará a los padres sobre el contenido para que estos puedan tener una discusión informada sobre el tema. Si el menor está entre los 13 y 17, no habrá reporte a los padres; sólo la notificación y validación de que quiere enviar/recibir el contenido.

Entonces, no es que si usted y su pareja están sexting felices de la dicha el sistema los vaya a reportar, ni a las autoridades ni a sus padres (bueno, a menos que usted tenga 12 años o menos y que su cuenta sea una cuenta infantil administrada como tal por parte de sus padres en Family Sharing, en cuyo caso le avisará a sus padres).

Nivel de controversia: medio. Principalmente de grupos LGBTI que temen que los padres super religiosos de niños y jóvenes homosexuales lo puedan usar para espiar a sus hijos.

2 – Nuevas capacidades en Siri y Search

La idea es que estas puedan para intervenir cuando los usuarios realicen búsquedas de consultas relacionadas con material que pueda ser catalogado como de Abuso Sexual de Menores (CSAM, por sus siglas en inglés).

Si este es el caso, estos explicarán a los usuarios que el interés en este tema es dañino y problemático, y proporcionarán recursos para obtener ayuda con este tema.

Nivel de controversia: bajo.

3 – Detección de Material asociado con el Abuso Sexual de Menores (CSAM)

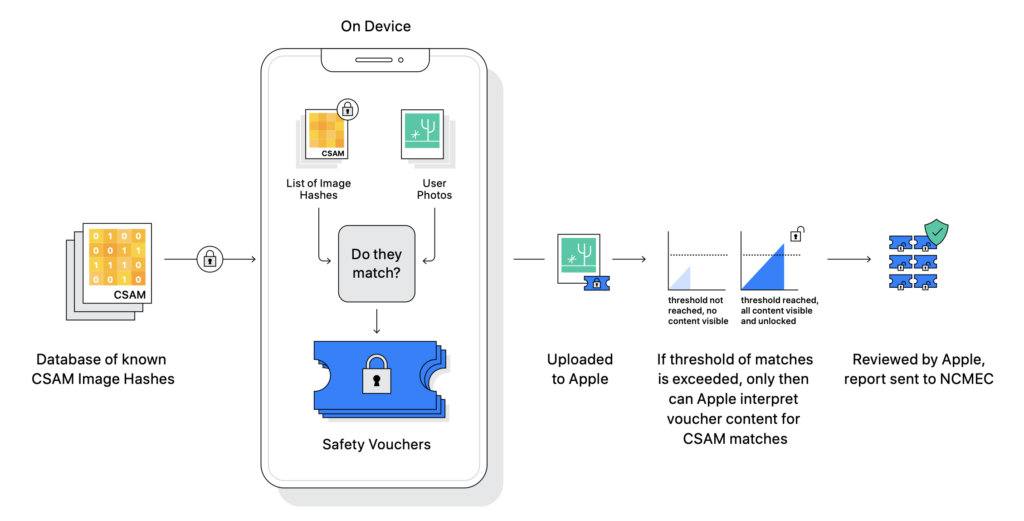

Mejor dicho detección de pornografía infantil en iCloud Photos.

Nivel de controversia: Aquí es donde se armó la debacle.

Toda foto que usted suba a iCloud Fotos (que, por ejemplo en mi caso y en el de muchos usuarios de Apple, son todas las fotos que tenemos y tomamos con cualquiera de nuestros dispositivos Apple) será “escaneada” y comparada con una base de datos de fotos pornográficas de menores provista por el National Center for Missing and Exploited Children (NCMEC) de Estados Unidos.

Temas importantes: 1) Esto aplica solo para usuarios en Estados Unidos y la compañía dice que la ampliación del sistema a otros países se hará “caso por caso”. 2) No es que Apple (ni ninguno de sus empleados o contratistas) vaya a mirar el contenido de sus fotos. El sistema toma una representación matemática de su foto (un “hash”) y la compara con los hashes de aquellas fotos contenidas en la base de datos del NCMEC dentro de unos “sobres” encriptados que, por si solos, no hacen sentido ni. para el teléfono de los usuarios ni para los servidores de iCloud. Es una tecnología criptográfica llamada private set intersection y en realidad funciona muy similar a como funciona Shazam para reconocer una canción (hace unos meses escribí sobre el tema).

Si el sistema encuentra un match guarda la información y cuando dicha cuenta pase de un “límite” de coincidencias el sistema generará un reporte a Apple para que alguien verifique el contenido y en caso de que se encuentre material pornográfico que involucre niños desactivará la cuenta y le enviará un reporte al NCMEC.

Apple dice que el sistema tiene un nivel de confiabilidad extremo y que garantiza que no existe un chance mayor a “1 en un trillón” de que una cuenta sea marcada por error.

Entonces, no es que si usted tiene una fotos de sus hijos pequeños bañándose en la tina el sistema lo vaya a reportar. El sistema solo reconoce fotos (o mejor hashes de fotos) reportadas a las autoridades previamente como material pornográfico que involucra menores de edad y que hacen match con aquellas que usted tiene en su librería de iCloud Fotos. Sólo esas. No parecidas, ni similares, ni con la misma composición de colores. Solo las mismas.

Ahora bien, dígame si sabía que compañías como Twitter, Microsoft, Google y Facebook ya hacen esto con las fotos que se almacenan y envían por medio de sus plataformas desde hace años.

Shock news, people – Twitter, Microsoft, lots of companies **do this already**. Facebook started in 2011. This is from a story I wrote in **2013**. https://t.co/8dKrm2mhj9 https://t.co/9UtDZCPJaS

— Charles Arthur (@charlesarthur) August 5, 2021

¿No? Bueno. Entonces bienvenido al mundo de las noticias relacionadas con Apple. Donde todo es hipérbola.

Nadie (cuerdo) cree que la pornografía infantil esté bien. Pero la preocupación nace, a mi entender, porque Apple ha creado una forma para que se analice el contenido de sus fotos (y por qué no de otro contenido) en su ecosistema contra una base de datos maestra; una puerta trasera.

Hoy tuve la oportunidad de hablar con la gente de Apple sobre el tema y hacerle algunas preguntas que creo son válidas.

¿Qué le garantiza a los usuarios que los gobiernos de ciertos países no creen bases de datos de otros temas y luego obliguen a Apple a buscar dicho contenido? Según Apple este sistema sólo funciona para fotos y sólo con bases de datos ya preseleccionadas que son administradas por entes de protección infantil.

¿Qué garantiza que el gobierno de Estados Unidos (que es donde sirve el sistema por ahora) encuentre una forma de explotar dicha tecnología sin que Apple y los usuarios sepan para perseguir a algunos de sus ciudadanos? La respuesta de Apple es que por años han recibido solicitudes (y exigencias) de diferentes gobiernos para crear puertas traseras que les permitan acceder a la información de sus usuarios y siempre se han negado a hacerlo, no está en el ADN de la compañía e iría en contra de los fundamentos de seguridad y privacidad que imprimen a sus productos y servicios.

¿Qué pasa si el gobierno (o alguien) comienza a poner en las bases de datos consultadas imágenes de, por ejemplo, gente que considera “enemigos del estado” y el sistema, al encontrar un número de coincidencias que supere el umbral bloquea la cuenta? Apple me ha dicho que 1) antes de reportar cualquier cuenta hay una validación manual del contenido para ver que, efectivamente, corresponda a una colección de fotos de pornografía infantil y no a errores o, en este caso hipotético, trampas que le quieran hacer el sistema y 2) el usuario puede apelar la decisión.

Pero además, Apple ha publicado un segundo documento (bueno en realidad varios documentos) que atiende varias de las preguntas, mitos y preocupaciones que han surgido en estos días con respecto al sistema y hace énfasis en las tecnologías y parámetros técnicos que ha incluido en el sistema y que están por encima de cualquiera implementado hasta ahora para preservar la privacidad de los usuarios “inocentes” a la vez que se asegura de erradicar de su plataforma de iCloud el contenido pornográfico que involucre menores de edad.

Creo que las discusiones son válidas. No porque la gente no confíe en Apple (aunque muchas personas no lo hacen) sino porque el sistema puede ser usado para otros fines, a pesar de las buenas intenciones con las que fue creado. Y por eso también creo que la discusión debe ser basada en la documentación técnica del servicio y no en supuestos o hipótesis sino en el track record de la compañía.

Veremos en qué termina la discusión.