La inteligencia artificial ha dejado de ser una promesa futurista para convertirse en una herramienta cotidiana en muchas empresas. Sin embargo, junto con su rápida adopción surge una preocupación silenciosa: el uso no autorizado y no supervisado de herramientas de IA dentro de las organizaciones, fenómeno conocido como Shadow AI (por si no recuerdan el artículo de Shadow IT de hace rato). Y aunque puede parecer inofensivo o incluso beneficioso, su proliferación plantea riesgos serios que no deben subestimarse.

¿Qué está detrás del auge de la Shadow AI?

En el fondo, la Shadow AI es el resultado de un conflicto entre agilidad e institucionalidad. Por un lado, los empleados buscan resolver tareas rápidamente utilizando herramientas que ya conocen —como ChatGPT, Midjourney o asistentes de escritura— sin necesidad de pasar por procesos internos que perciben como lentos o restrictivos. Por otro lado, los departamentos de TI y seguridad ven cómo su capacidad de supervisar el uso de tecnologías en la empresa se diluye ante esta ola de experimentación no autorizada.

La accesibilidad de la IA y la falta de formación sobre sus implicaciones crean el caldo de cultivo perfecto para que esta práctica florezca. Y aunque muchas veces parte de la buena voluntad, el problema está en lo que no se ve: riesgos de seguridad, cumplimiento normativo y dependencia tecnológica.

El otro lado del espejo: peligros reales

El uso de herramientas de IA sin control puede derivar en filtración de datos sensibles (como estrategias comerciales, datos de clientes o propiedad intelectual, ya hay ejemplos de casos así) especialmente cuando se interactúa con plataformas que almacenan o entrenan sus modelos con información del usuario. Además, se corre el riesgo de incumplir normativas como el GDPR o leyes locales de protección de datos, lo que puede derivar en multas millonarias.

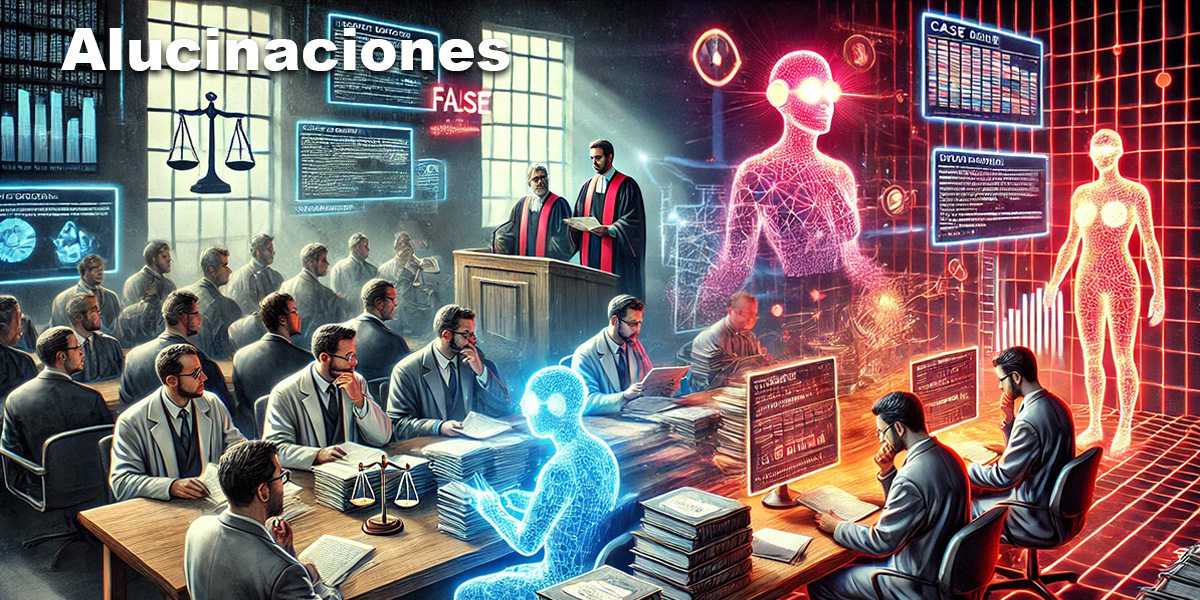

Otro riesgo subestimado es el de las “alucinaciones” de la IA: datos falsos, respuestas incorrectas o inferencias erróneas que, si se toman como ciertas, pueden afectar decisiones estratégicas. Y en un entorno donde cada segundo cuenta, una mala decisión basada en un resultado generado por IA no supervisada puede costar caro.

¿Prohibir o integrar?

El impulso natural podría ser restringir por completo estas prácticas. Sin embargo, esto sería ir contra corriente. Un enfoque más estratégico pasa por establecer políticas claras, educar al equipo, y sobre todo, ofrecer alternativas seguras. Si los empleados tienen acceso a herramientas aprobadas, seguras y útiles, habrá menos incentivos para buscar opciones por fuera del radar.

La colaboración entre áreas es clave. TI no debe ser un muro, sino un socio. Y los empleados deben entender que usar IA no es un juego: puede mejorar su productividad, sí, pero también comprometer la empresa si se usa de manera irresponsable.

En un momento en que la inteligencia artificial define la ventaja competitiva, el verdadero liderazgo será de aquellas organizaciones que sepan equilibrar la innovación con la responsabilidad.