En TECHcetera llevamos hablando sobre el tema desde hace años pero, hoy en día, la ética a nivel de la inteligencia artificial está dejando de ser un concepto futurista para convertirse en un componente esencial de las decisiones que afectan la vida de millones de personas: desde la aprobación de un crédito hasta una entrevista de trabajo, pasando por recomendaciones médicas o sentencias judiciales asistidas por algoritmos. En este escenario, una pregunta cobra cada vez más urgencia: ¿es ética la IA que usamos hoy?

La respuesta, según expertos en el tema, no depende de las máquinas, sino de nosotros. Y es ahí donde comienza una conversación incómoda pero necesaria: la ética en la inteligencia artificial no es una opción —es algo imperativo a nivel de los proyectos empresariales.

Lo que revela IBM: oportunidades y brechas en la ética de la IA en América Latina

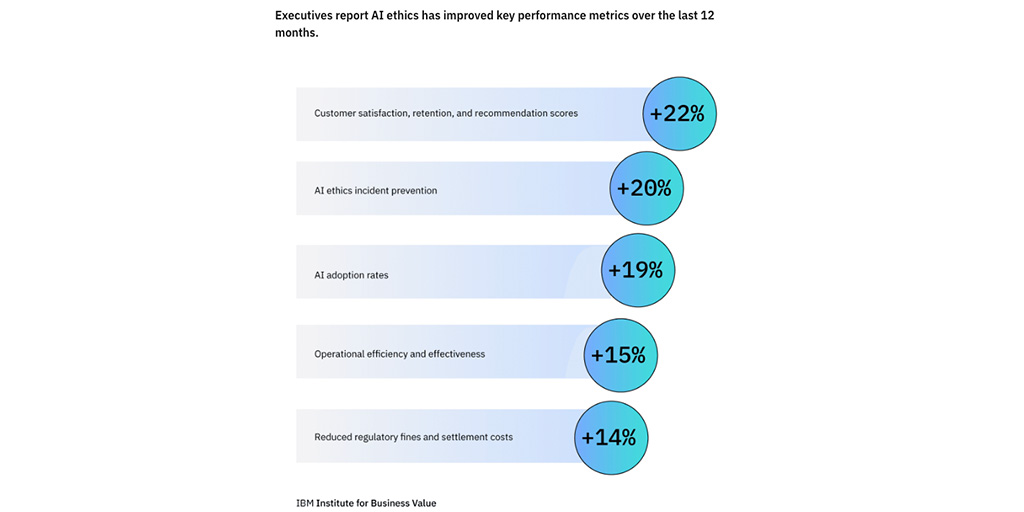

Un reciente estudio del IBM Institute for Business Value, en colaboración con el Notre Dame‑IBM Tech Ethics Lab, ofrece una radiografía precisa sobre el estado actual de la inteligencia artificial ética en América Latina. Los hallazgos revelan tanto un avance importante en términos de percepción como un rezago preocupante en la implementación práctica.

Para empezar, los resultados muestran que los beneficios de adoptar prácticas éticas en IA son tangibles. Un 57% de los ejecutivos encuestados en la región afirma que estas iniciativas han fortalecido la confianza de los clientes y mejorado la calidad de los productos. A nivel global, las compañías que destinan mayores recursos a IA ética han visto hasta un 30% más de beneficios operativos relacionados con inteligencia artificial, en comparación con aquellas que invierten menos en este campo.

Sin embargo, pese a estas señales alentadoras, la adopción de marcos éticos todavía es limitada. Solo un 34% de los líderes en Latinoamérica reconoce utilizar herramientas básicas de IA ética. Más preocupante aún, el 60% admite que sus marcos actuales no están preparados para hacer frente a la creciente autonomía de los sistemas de IA. De cara al futuro, el 68% cree que será indispensable establecer normas éticas aún más estrictas para los nuevos agentes de inteligencia artificial.

Las barreras para lograr esta transformación son múltiples. Por un lado, persisten desafíos conceptuales: más de la mitad de los ejecutivos señala que la explicabilidad, el sesgo y la confianza siguen siendo obstáculos críticos para la adopción de IA ética. Por otro lado, las tensiones internas dentro de las empresas son evidentes: el 69% reporta conflictos entre los objetivos comerciales y los valores éticos, lo que refleja una falta de alineación estratégica. A esto se suman dificultades operativas, como la escasez de talento especializado (69%), la limitada capacidad para formar equipos a gran escala (57%) y la falta de recursos financieros adecuados (57%).

El peligro de los sesgos invisibles

Uno de los principales riesgos de la IA radica en su alimento: los datos. Si los datos están sesgados —por prejuicios históricos, desigualdades estructurales o simples errores de muestreo— los algoritmos van a perpetuar y amplificar esas mismas injusticias. Y lo hacen con apariencia de objetividad pura y matemática.

Como se señala en el video, las máquinas no son simplemente actores neutrales. Pueden decidir quién recibe un préstamo, quién pasa a una segunda entrevista, quién es monitoreado más intensamente por una aseguradora. Pero si no sabemos cómo se tomaron esas decisiones, estamos cediendo demasiado poder a una caja negra.

¿Cuáles son los cuatro pilares de una IA ética?

Para evitar que la IA se convierta en una fuente de decisiones opacas e injustas, se proponen cuatro pilares fundamentales:

1. Explicabilidad: El usuario tiene derecho a saber por qué fue aprobado o rechazado por un sistema automatizado. Las empresas deben poder explicar qué variables usó el algoritmo y cómo las combinó.

2. Trazabilidad: Debe ser posible seguir el camino exacto que tomó la IA para llegar a una decisión. Esta “huella digital” del pensamiento algorítmico permite identificar errores, corregir sesgos y rendir cuentas.

3. Transparencia: Implica ser claro sobre cómo se usan los datos, con qué herramientas y bajo qué criterios. En un mundo donde los ciudadanos exigen cada vez más control sobre su información, esto ya no es opcional.

4. Apertura: Fomentar entornos donde herramientas de diferentes proveedores puedan coexistir bajo un sistema común de gobernanza ética. Esto es especialmente crucial en empresas que usan múltiples soluciones de IA.

Nuevas responsabilidades

Abordar la ética en la IA requiere más que buenas intenciones. Exige una transformación organizacional. Cada vez más empresas están creando figuras como responsables de ética en IA, además de formar comités multidisciplinarios que incluyan áreas legales, de tecnología, recursos humanos y gobierno corporativo.

La ética no puede ser un “parche” añadido al final de un proyecto. Debe estar integrada desde el diseño de la aplicación y mantenerse a lo largo de todo su ciclo de vida, con sistemas automatizados que verifiquen sesgos, inconsistencias y desviaciones.

Una IA ética no solo cumple la ley: genera impacto positivo en el negocio y en la sociedad.

Entonces… ¿de quién es la culpa si decide la máquina?

La inteligencia artificial no es buena ni mala por sí sola. Lo que determina su impacto es cómo la diseñamos, entrenamos, gobernamos y auditamos. En última instancia, la responsabilidad de cada decisión automatizada sigue siendo humana. Y mientras más poder damos a la tecnología, más necesitamos mecanismos para rendir cuentas, algo que en artículos anteriores, denominabamos como IA Explicable.

El futuro no necesita solo algoritmos más potentes, sino más justos, transparentes y humanos. Porque si la IA va a tomar decisiones por nosotros, entonces más nos vale asegurarnos de que piense —y actúe— éticamente.