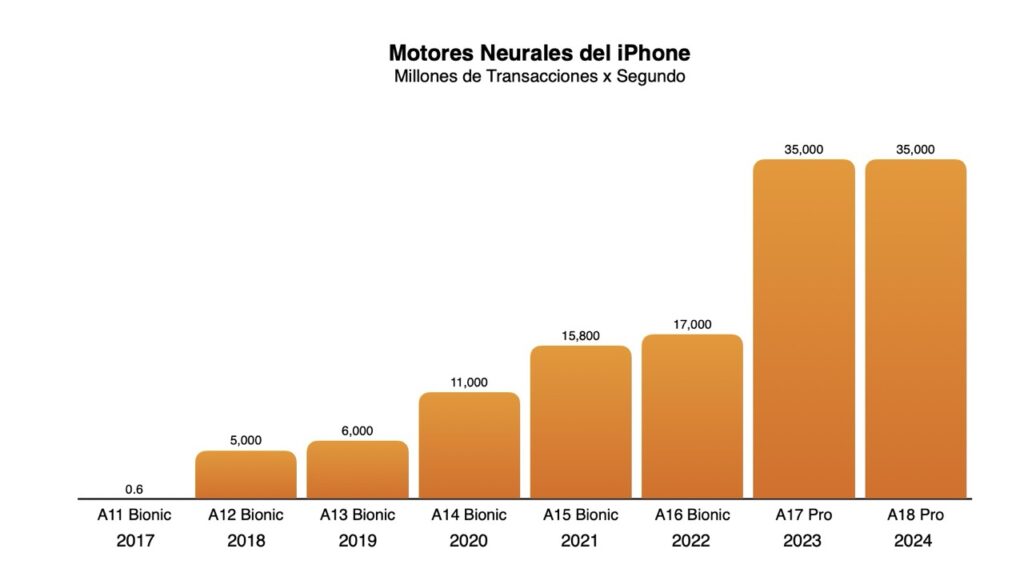

En Septiembre del 2017, junto con el lanzamiento del iPhone X, Apple lanzó el A11 Bionic, su primer chip en incorporar una Motor Neuronal: un chip de dos núcleos que podía realizar hasta 600 mil millones de operaciones por segundo para el procesamiento en tiempo real de algoritmos de aprendizaje automático.

Desde entonces, y mientras la competencia buscaba cómo incorporar este tipo de tecnología en sus dispositivos (algo que llegó, por fin, el año pasado), Apple ha venido integrando y perfeccionando el Motor Neuronal en todos sus chips al punto que con el A18 Pro del año pasado, que tiene 16 cores, el sistema puede procesar hasta 35 mil millones de operaciones por segundo.

Y aunque del A17 Pro al A18 Pro no vimos incrementos ni el número de Cores ni en la cantidad de TOPS (Tera Operations per Second) lo que si vimos fue un aumento en su velocidad de procesamiento de 20% y una mejora de cerca de 17% en la eficiencia energética de dicho componente.

A19 Pro

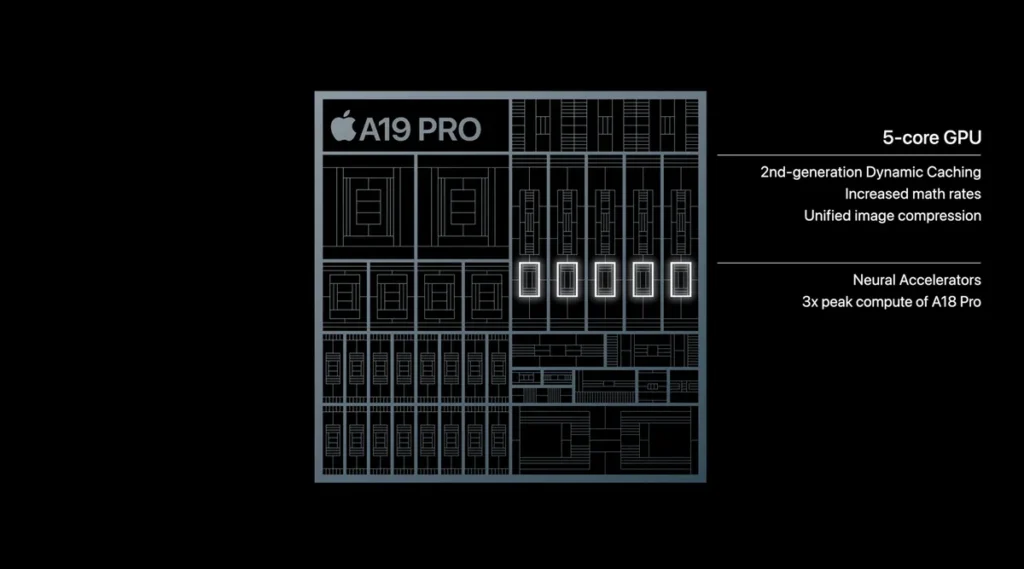

Ahora, con la llegada del A19 Pro a los iPhone 17 Pro y Pro Max y al iPhone Air, la compañía ha presentado su nuevo Chip, el A19 Pro. Y fue poco (o nada) lo que habló del Motor Neuronal del Chip, que sabemos sigue teniendo 16 cores (pero no sabemos mucho más). En cambio, la compañía se concentró en un nuevo componente de su GPU: 5 aceleradores neuronales (uno para core de la GPU) que, de acuerdo con la documentación provista, pueden ofrecer 3x la capacidad de cómputo máxima del A18 Pro para cargas asociadas con Machine Learning, Inteligencia Artificial y renderización de imágenes y video. 3x!!!!

Los aceleradores neuronales del chip A19 Pro tienen un diseño similar al Tensor Core de NVIDIA y su fin principal es el de acelerar -valga la redundancia- las tareas de aprendizaje automático e inteligencia artificial (IA). A diferencia del Motor Neuronal del A19 Pro estos aceleradores se integran directamente en cada núcleo de GPU para manejar operaciones específicas y computacionalmente intensivas de manera más eficiente y con una latencia muchísimo menor, permitiéndole al A19 Pro manejar tareas complejas como el reconocimiento de imágenes en tiempo real, los modelos de IA generativa y la fotografía computacional mucho más rápido que los chips anteriores. Con esta arquitectura Apple minimiza la necesidad de que la GPU transfiera datos al Motor Neuronal para su procesamiento.

Si bien su nombre sugiere un enfoque en temas de Inteligencia Artificial, los aceleradores neuronales pegados a los 5 cores de la GPU, son cruciales para el rendimiento gráfico de alta gama, requeridos para poder correr títulos de juegos AAA que cuentan con efectos gráficos exigentes, como el trazado de rayos acelerado por hardware y velocidades de fotogramas más altas. Los aceleradores están optimizados para las operaciones de multiplicación de matrices que son el núcleo de las cargas de trabajo de IA y la representación gráfica avanzada, lo que les permite trabajar en conjunto con la GPU para ofrecer imágenes impresionantes y una experiencia de juego más fluida.

En el evento de la semana pasada, hubo una frase de Tim Millet, el VP Platform Architecture de la compañía, que me llamó la atención:

This is MacBook Pro levels of compute in an iPhone, perfect for GPU-intensive AI workloads.

¿Niveles computación del MacBook Pro en el iPhone? Wow. ¿Será verdad que los iPhone ahora pueden competir de tú a tú con los MacBook? Mire los resultados de 3 chips: el A18 Pro, el A19 Pro y el M2:

El A19 Pro no solo esta casi a la par en términos de procesamiento (CPU) sino de procesamiento de gráficos (GPU) que un chip de computador de hace menos de 24 meses. Y esa GPU también se usa para el procesamiento de tareas relacionadas con IA.

Así que con el A19 Pro Apple vuelve a demostrar que tiene las bases de hardware necesarias para que todos los desarrolladores (sin importar su tamaño) puedan diseñar sus aplicaciones para el procesamiento nativo y local de tareas de IA ofreciendo la máxima Privacidad (dado que los datos se procesan en el dispositivo, no es necesario enviarlos a la nube, lo que mejora la privacidad del usuario), Velocidad (el procesamiento en el dispositivo es mucho más rápido porque elimina la latencia de la comunicación en red y Eficiencia (al descargar tareas específicas de la CPU y la GPU principal, los aceleradores neuronales mejoran la eficiencia energética general), y que está en otra liga.