¿Artistas: ahora pueden envenenar a la IA? Es importante saber que, una nueva herramienta permite a los artistas añadir cambios invisibles a los píxeles de su arte antes de subirlo en línea, de modo que si se incluye en un conjunto de entrenamiento de Inteligencia Artificial (IA), puede causar que el modelo resultante se rompa de manera caótica e impredecible.

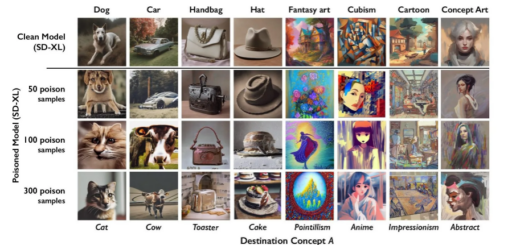

La herramienta, denominada “Nightshade”, pretende ser una forma de luchar contra las empresas de IA que utilizan el trabajo de los artistas para entrenar sus modelos sin el permiso del creador. Usarlo para “envenenar” estos datos de entrenamiento podría dañar futuras iteraciones de modelos de Inteligencia Artificial generadores de imágenes, como lo son; DALL-E, Midjourney y Stable Diffusion, al inutilizar algunos de sus resultados: los perros se convierten en gatos y los automóviles en vacas, por ejemplo.

Envenenar a la IA

Según se ha podido conocer, empresas de Inteligencia Artificial (IA) como; OpenAI, Meta, así como también Google y Stability AI se enfrentan a una serie de demandas de artistas que han afirmado que su material protegido por derechos de autor y su información personal fueron eliminados sin consentimiento ni compensación. Ben Zhao, quien es profesor de la Universidad de Chicago, que dirigió el equipo que creó Nightshade, señala que la esperanza es que ayude a inclinar el equilibrio de poder de las empresas de IA hacia los artistas, al crear un poderoso y fuerte elemento disuasorio contra la falta de respeto a los derechos de autor e intelectuales de los artistas.

Además, cabe destacar que el equipo de Zhao también desarrolló Glaze, la cual es una herramienta que permite a los artistas “enmascarar” su estilo personal para evitar que las empresas de Inteligencia Artificial lo eliminen. Según se informa, logra funcionar de manera similar a Nightshade: cambiando los píxeles de las imágenes de maneras sutiles que son invisibles para el ojo humano pero manipulan modelos de aprendizaje automático para interpretar la imagen como algo distinto de lo que verdaderamente muestra.

Según se conoce, el equipo tiene la intención de integrar Nightshade en Glaze y los artistas tienen la capacidad de poder elegir si quieren usar la herramienta de envenenamiento de datos o no. Incluso, el equipo también está haciendo que Nightshade sea de código abierto, lo que permitiría a otros jugar con él y así mismo, crear sus propias versiones. Cuanta más gente la utilice y cree sus propias versiones, más poderosa se vuelve la herramienta, menciona Zhao. Los conjuntos de datos para grandes modelos de Inteligencia Artificial pueden consistir en miles de millones de imágenes, por lo que cuantas más imágenes envenenadas se puedan incorporar al modelo, más daño causará la técnica.

Un ataque dirigido

Nightshade explota una vulnerabilidad de seguridad en los modelos de Inteligencia Artificial Generativa, que surge del hecho de que están entrenados con grandes cantidades de datos (en este caso, imágenes extraídas de Internet). Nightshade se mete con esas imágenes.

Vale la pena mencionar que, los artistas que quieran subir su trabajo en línea pero no quieran que las empresas de IA eliminen sus imágenes pueden subirlas a Glaze y optar por enmascararlas con un estilo artístico diferente al suyo. Luego también tienen la capacidad de poder optar por utilizar Nightshade. Una vez que los desarrolladores de Inteligencia Artificial buscan en Internet para obtener más datos para modificar un modelo de IA existente o construir uno nuevo, estas muestras envenenadas llegan al conjunto de datos del modelo y provocan un mal funcionamiento.

Las muestras de datos envenenadas tienen la capacidad de poder manipular los modelos para que aprendan, por ejemplo, que las imágenes de sombreros son pasteles y las imágenes de bolsos son tostadoras. Según se pudo conocer, los datos envenenados son muy difíciles de eliminar, debido a que requiere que las empresas de tecnología encuentren y eliminen escrupulosamente cada muestra corrupta.

Los investigadores probaron el ataque en los últimos modelos de Stable Diffusion y en un modelo de Inteligencia Artificial (IA) que ellos mismos entrenaron desde cero. Cuando alimentaron a Stable Diffusion con solo 50 imágenes de perros envenenados y luego le solicitaron que creara imágenes de perros, el resultado comenzó a parecer bastante extraño; criaturas con demasiadas extremidades y así mismo, con rostros caricaturescos. Con 300 muestras envenenadas, un atacante tiene la capacidad de poder manipular Stable Diffusion para generar imágenes de perros que parecen gatos.

Ahora bien, los modelos de IA generativa son excelentes para establecer conexiones entre palabras, lo que ayuda a que el veneno se propague. Nightshade infecta no sólo la palabra “perro”, sino también todos los conceptos similares, como por ejemplo; cachorro, husky y lobo. El ataque de veneno también logra funcionar con imágenes relacionadas tangencialmente. Por ejemplo, si el modelo extrajo una imagen envenenada para el mensaje “arte de fantasía”, los mensajes “dragón” y así mismo, “un castillo en El Señor de los Anillos” por ejemplo, serían manipulados de forma similar para convertirlos en otra cosa.

Zhao ha admitido que existe el riesgo de que las personas abusen de la técnica de envenenamiento de datos para usos maliciosos. Sin embargo, ha señalado que los atacantes requerirían miles de muestras envenenadas para infligir un daño real a modelos más grandes y potentes, debido a que están entrenados con miles de millones de muestras de datos.

Un poderoso y fuerte elemento disuasivo

Junfeng Yang, quien es profesor de informática en la Universidad de Columbia, que ha estudiado la seguridad de los sistemas de aprendizaje profundo y no participó en el trabajo, señala que Nightshade podría tener un gran impacto si hace que las empresas de IA respeten más los derechos de los artistas, por ejemplo, al estar más dispuestos a pagar regalías.

Las empresas de IA que han desarrollado modelos generativos de texto a imagen, como Stability AI y OpenAI por ejemplo, han ofrecido permitir que los artistas opten por no usar sus imágenes para entrenar versiones futuras de los modelos. Pero los artistas han señalado que esto no es suficiente. Algunos artistas han comentado que herramientas como Nightshade y Glaze le han dado la confianza para volver a publicar su trabajo en línea.