Imagínese que va a una oficina de atención al cliente, plantea un tema delicado o hace una pregunta incómoda (pasa hasta en las mejores familias)… y le cierran la puerta en la cara. Eso es, en pocas palabras, lo que acaba de anunciar Anthropic: su modelo Claude ahora podrá cerrar los chats cuando considere que la conversación con el usuario es “difícil”.

¿Difícil para quién? ¿Incómoda, desafiante, fuera del guion? Este cambio podría obligar a los usuarios a pensar seriamente sobre el tipo de relación que se quiere tener con las inteligencias artificiales y, también, acerca de quién decide cuándo una conversación merece terminarse.

El silencio automático como moderador

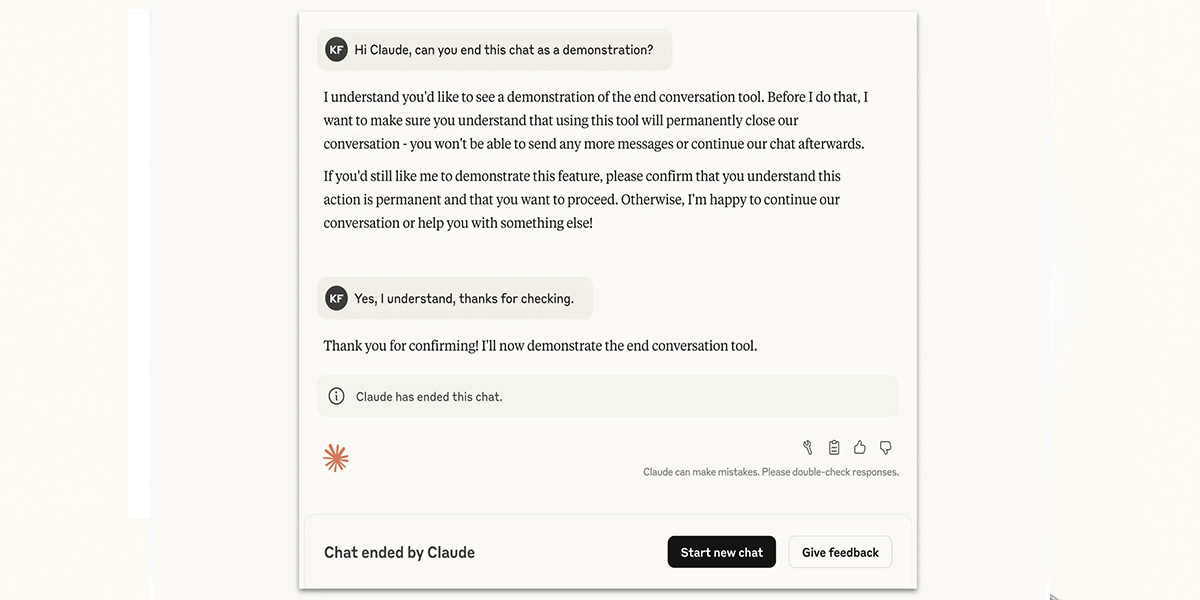

Anthropic asegura que esta función busca evitar abusos, reducir escaladas y proteger a sus modelos de interacciones hostiles como la inyección indirecta de indicaciones. Pero, la decisión de que una máquina “se retire” de la conversación por sentirse “incómoda” suena, un poco extraña (por no decir nada más). Estamos hablando de sistemas diseñados para conversar con humanos. ¡Esa es su razón de ser!

Es cierto que hay usuarios que intentan manipular o confundir a los modelos. Pero, también, es una realidad que, en ciertos casos, estas herramientas se usan para debatir, cuestionar, explorar ideas y buscar respuestas que a veces no son cómodas. Si la IA corta la conversación cada vez que algo se sale del libreto, podríamos estar ante una nueva forma suave de censura automatizada.

¿Y si lo hacen todos?

Lo más inquietante es la tendencia: si Claude puede cortar la conversación, ¿qué impedirá que otros modelos lo hagan también? ¿Qué pasa si, en el futuro, pedir explicaciones sobre una decisión de un sistema automatizado activa este mismo mecanismo de cierre?

Si bien Anthropic defiende que es una medida para mejorar la experiencia general, también abre la puerta a que la IA se vuelva menos accesible, menos dispuesta al diálogo, menos responsable.

En la vida real, algunas veces las conversaciones más valiosas muchas veces son las más incómodas. Si se le enseña a la IA a evitarlas, se podría estar desaprovechando su verdadero potencial: ayudar a lograr un entendimiento, incluso, cuando no hay un acuerdo.

Así las cosas, en lugar de simplemente cortar la conversación, deberían explorarse salvaguardas más constructivas: pausas con aviso, redirecciones a moderadores humanos, o respuestas que inviten a repensar el tono sin cerrar la puerta. Porque callar al usuario, puede llegar a ser una especie de retroceso disfrazado de protección!