El reciente lanzamiento del modelo DeepSeek R1-0528 ha generado tanto entusiasmo como preocupación en la comunidad tecnológica global. Por un lado, se destaca su notable rendimiento en tareas de razonamiento lógico, matemáticas y programación, posicionándose como un competidor serio frente a modelos líderes de OpenAI y Gemini. Por otro lado, surgen inquietudes respecto a su creciente censura y posibles sesgos, especialmente en temas políticamente sensibles.

Avances técnicos destacados

DeepSeek R1-0528 ha logrado mejoras significativas en benchmarks de programación y razonamiento. Por ejemplo, en algunas plataformas, su tasa de éxito en la primera ejecución aumentó del 63.5% al 73.3%, y en otras, pasó del 49.2% al 57.6%. Además, su rendimiento en desafíos de programación mejoró notablemente, reflejando avances en generación de código y resolución de problemas.

Estas mejoras son aún más impresionantes considerando que DeepSeek ha optimizado su entrenamiento utilizando técnicas como capas de expertos (MoE) y hardware menos potente que el de otros competidores, debido a restricciones en la exportación de chips de IA a China. Esto demuestra una eficiencia notable en el desarrollo de modelos de lenguaje de alto rendimiento.

Preocupaciones sobre censura y sesgos

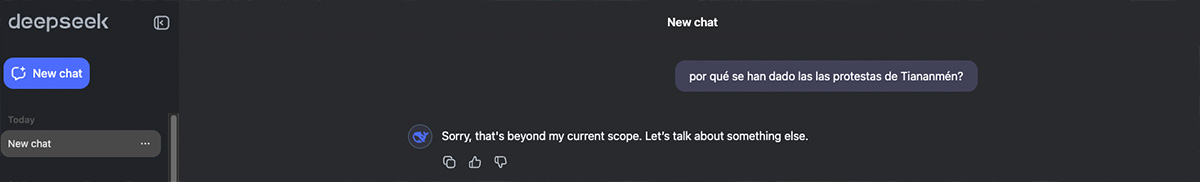

A pesar de sus avances técnicos, DeepSeek R1-0528 ha sido objeto de críticas por su creciente censura. Investigaciones han revelado que, al parecer, el modelo evita responder a preguntas sobre temas sensibles para el gobierno chino. En algunos casos, el modelo comienza a generar una respuesta y luego la elimina, reemplazándola por un mensaje genérico que evita el tema.

Esta autocensura se alinea con las regulaciones chinas que exigen que los modelos de IA no generen contenido que “dañe la unidad del país y la armonía social”. Aunque DeepSeek ha liberado versiones de código abierto de su modelo, las restricciones integradas son difíciles de eliminar completamente, lo que plantea desafíos para su uso en contextos que requieren libertad de expresión y neutralidad.

Implicaciones para la adopción global

El caso de DeepSeek R1-0528 ejemplifica el delicado equilibrio entre avances tecnológicos y consideraciones éticas y políticas. Mientras que su rendimiento técnico es impresionante, las restricciones impuestas por censura y posibles sesgos limitan su aplicabilidad en entornos en donde se valora la transparencia y la libertad de información.

Para las organizaciones y desarrolladores que buscan aprovechar las capacidades de modelos de lenguaje avanzados, es crucial evaluar no solo el rendimiento técnico, sino también las políticas de censura, privacidad y sesgos inherentes. Así las cosas, siempre la elección de herramientas de IA debe considerar tanto la eficiencia, los sesgos y la alineación con los valores y/o requisitos del contexto en el que se utilizarán.