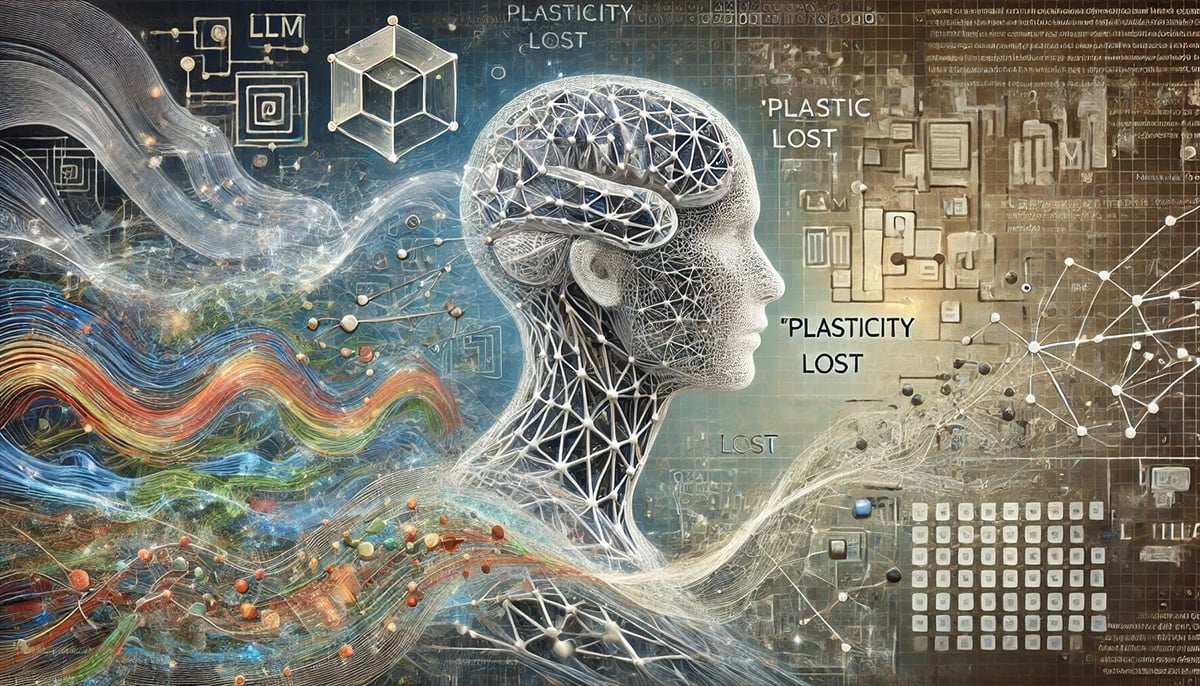

Los Modelos de Lenguaje de gran tamaño (LLMs, por sus siglas en inglés) como GPT-3 o GPT-4 han revolucionado la manera en que interactuamos con la inteligencia artificial. Sin embargo, estos modelos enfrentan un desafío interesante: “Plasticity Lost” o “plasticidad perdida”. Este término describe cómo, a medida que estos modelos se entrenan más y más, comienzan a perder su capacidad para aprender cosas nuevas de manera efectiva. ¿Pero por qué ocurre esto y qué podemos hacer al respecto?

¿Qué es eso de la Plasticidad Perdida?

En términos simples, la plasticidad en un modelo de lenguaje se refiere a su capacidad para aprender nueva información y adaptarse a cambios sin olvidar lo que ya ha aprendido. Cuando hablamos de “plasticidad perdida”, nos referimos a una situación en la que el modelo se vuelve más rígido, dificultando su adaptación a nueva información. Es como un estudiante que, después de estudiar durante años, su cerebro se vuelve terco y se resiste a aprender algo nuevo.

¿Cómo afecta la Plasticidad Perdida a los LLMs?

Imagina que tienes un modelo de lenguaje entrenado para entender y generar texto sobre miles de temas diferentes. Con el tiempo, este modelo puede empezar a “olvidar” cómo adaptarse a nuevas ideas. En lugar de absorber nueva información y ajustarse, el modelo puede rechazarla o integrarla de una manera que dañe lo que ya sabe, como lo que pasaba anteriormente con los “CDs no regrabables” que, se quedaban sin memoria y para guardar algo nuevo, sin capacidad para liberar espacio y poco a poco iban quedando desactualizados y obsoletos. Esto puede resultar en respuestas menos precisas o actualizadas y puede terminar generando los temidos delirios y alucinaciones.

Posibles soluciones al problema de la Plasticidad Perdida?

Al parecer, los investigadores están desarrollando métodos para mantener la plasticidad en los LLMs y superar este obstáculo.

Entrenamiento Continuo y Modularidad

Una posible solución es el entrenamiento continuo y la modularidad en el diseño de los modelos. Este enfoque podría permitir que los modelos aprendan de manera incremental, incorporando nueva información sin afectar su base de conocimientos preexistente. Al dividir el conocimiento en módulos, los LLMs pueden actualizarse en áreas específicas sin alterar otras partes del modelo.

Un Vistazo al Futuro

Un estudio reciente publicado en Nature sugiere un enfoque novedoso para abordar este problemita que tiene a muchos tan preocupados. Los investigadores han propuesto un método que permite a los LLMs mantener su capacidad de aprendizaje mediante la regulación del “estado plástico” del modelo. Esto implica ajustar dinámicamente la arquitectura del modelo para que algunas partes mantengan su capacidad de aprender, mientras otras se estabilizan para proteger el conocimiento ya adquirido (Consilium). Esta estrategia podría ser clave para mejorar la longevidad y eficacia de los LLMs, asegurando que continúen aprendiendo sin volverse rígidos.

Y… Entonces?

Aunque la “plasticidad perdida” es todo un desafío importante para los LLMs, no parece ser insuperable. Con avances como el entrenamiento continuo y enfoques modulares, además de las investigaciones más recientes, es posible mantener los modelos modelos “relativamente” flexibles y adaptables. A medida que la inteligencia artificial continúa evolucionando, encontrar el equilibrio adecuado entre estabilidad y plasticidad será crucial para el desarrollo de modelos de lenguaje que puedan seguir siendo relevantes y útiles en un mundo en constante cambio.