¡Microsoft tiene un modelo de IA para crear video de gente hablando! Y es que la compañía ha presentado “VASA”, un marco para generar caras parlantes realistas de personajes virtuales con atractivas habilidades afectivas visuales (VAS), a partir de una única imagen estática y así mismo, un clip de audio de voz. Su primer modelo, VASA-1, es capaz no sólo de producir movimientos de labios excelentemente sincronizados con el audio, sino también de capturar un extenso espectro de matices faciales y movimientos naturales de la cabeza que contribuyen a la percepción de autenticidad y vivacidad.

Vale la pena señalar que, las innovaciones principales incluyen una dinámica facial holística y un modelo de generación de movimiento de la cabeza que funciona en un espacio latente del rostro, y el desarrollo de un espacio latente del rostro tan expresivo y desenredado mediante vídeos. Mediante extensos experimentos que incluyen la evaluación de un conjunto de nuevas métricas, desde Microsoft han demostrado que su método supera significativamente a los métodos anteriores en diversas dimensiones de forma integral. No solo proporciona alta calidad de video con dinámicas faciales y de cabeza realistas, sino que también admite la generación en línea de videos de 512×512 a hasta 40 FPS con una latencia inicial insignificante. Desde la compañía han señalado que, allana el camino para interacciones en tiempo real con avatares realistas que emulan comportamientos conversacionales humanos.

Un modelo de IA para crear video de gente hablando; “VASA”

Hay varios aspectos que se tienen que conocer y a continuación los presentamos:

Realismo y vivacidad

El método es capaz no sólo de producir una admirable sincronización de audio entre labios, sino también de generar un extenso espectro de matices faciales expresivos y movimientos naturales de la cabeza. Tiene la capacidad de poder manejar audio de longitud arbitraria y generar de forma estable videos de caras parlantes sin interrupciones.

Control de la generación

El modelo de difusión de Microsoft acepta señales opcionales como condición, como la dirección de la mirada principal y la distancia de la cabeza, y así mismo, compensaciones de emociones.

Generalización fuera de distribución

Su método muestra la capacidad de manejar entradas de fotos y audio que están fuera de la distribución del entrenamiento. Por ejemplo, tiene la capacidad de poder manejar fotografías artísticas, audios de canto y habla en idiomas distintos del inglés. Cabe acotar que, estos tipos de datos no estaban presentes en el conjunto de entrenamiento.

Desenredo

La representación latente desenreda la apariencia, la pose de la cabeza en 3D y la dinámica facial, lo que permite el control de atributos y de igual forma, la edición por separado del contenido generado.

Eficiencia en tiempo real

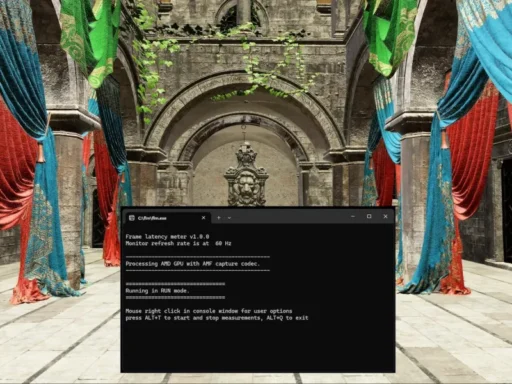

El método de Microsoft genera cuadros de video de tamaño 512×512 a 45 fps en el modo de procesamiento por lotes fuera de línea y tiene la posibilidad de admitir hasta 40 fps en el modo de transmisión en línea con una latencia anterior de solo 170 ms, evaluada en una PC de escritorio con una única GPU NVIDIA RTX 4090.

Desde Microsoft han señalado que, por el momento, no tienen planes de publicar una demostración en línea, API, producto, o detalles de implementación adicionales ni ninguna oferta relacionada hasta que estén seguros de que la tecnología se usará de manera responsable y de acuerdo con las regulaciones adecuadas.