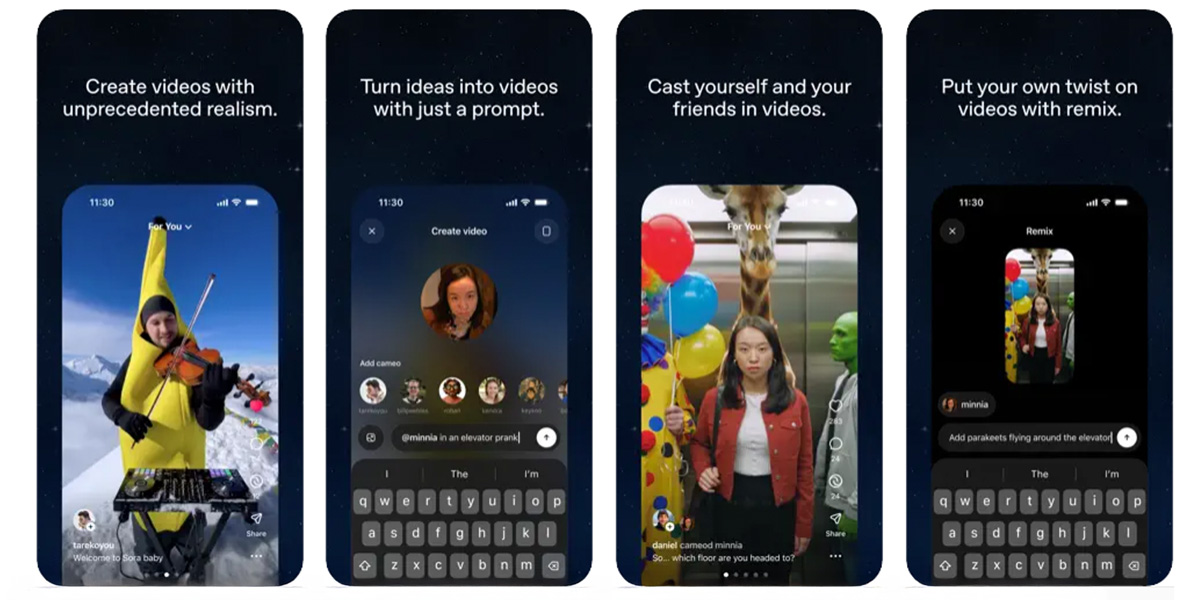

La función cameo de herramientas como Sora 2 de OpenAI promete algo que suena mágico: permitirle al usuario insertarse en un video generado por IA con su propio rostro y voz, en teoría controlando quién puede usar esa imagen. OpenAI lo presenta como una función de opt‑in, una forma de dar consentimiento explícito para la aparición digital.

Pero detrás de esa promesa se despliega un territorio peligroso. Porque si alguien puede “incrustarte” en videos convincentes, con su rostro y su voz, ¿dónde termina la persona real y comienza el doble digital? Ese límite se vuelve borroso, y con ello surgen riesgos inéditos para la identidad, la reputación y la justicia.

Riesgos legales: cuando la “evidencia audiovisual” deja de ser fiable

Uno de los efectos más inquietantes del cameo de IA es el debilitamiento de lo que se considera evidencia audiovisual. En los tribunales, imágenes o grabaciones han sido históricamente pruebas robustas: un video de un acto, una confesión, una autoridad diciendo algo. Pero si alguien puede recrear un video falso donde aparece una persona haciendo algo que nunca hizo, ese tipo de pruebas podrían dejar de tener valor.

Imagine un video deepfake de alta fidelidad donde “confiesa” algo o da una orden. Esa manipulación puede ser tan sutil que las herramientas forenses actuales no lo detecten. Entonces se afecta el debido proceso: ¿cómo refutar algo que parece real, que fue creado con su rostro? La presunción de inocencia queda en jaque.

Algunas legislaciones ya comienzan a reaccionar: en ciertos casos se discute considerar el uso malintencionado de IA para suplantación de identidad como un agravante, precisamente porque no es solo un daño reputacional sino un ataque al núcleo legal de la verdad.

Suplantación y chantaje: el deepfake como nueva arma de fraude

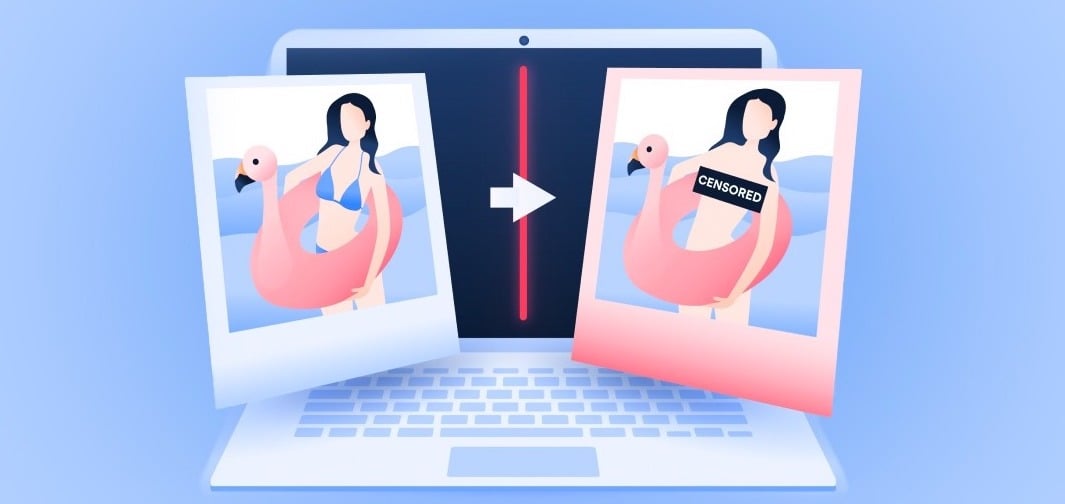

Si crear un cameo es fácil, usarlo para cometer delitos financieros se vuelve tentador. Podría recibir un video con la voz de su jefe ordenando transferencias, o alguien hacerse pasar por un familiar en crisis, intimidando con pruebas falsas. Esa amenaza no es ciencia ficción: ya tenemos casos de fraude al CEO mediante llamadas deepfake de audio o políticos diciendo y haciendo cosas que nunca sucedieron en video, inclusive, hasta clones sintéticos de personas reales que aparecen sin ropa (como por arte de magia).

Todavía más: muchos sistemas de seguridad biométrica usan reconocimiento facial o de voz. Un rostro o voz clonada con suficiente grado de realismo podría llegar a sobrepasar esas defensas automáticas. Eso vuelve obsoletos muchos controles digitales que considerábamos seguros.

Y no solo es dinero: el chantaje con contenido íntimo falsificado, declaraciones falsas o escenas comprometedoras puede destruir reputaciones, carreras o relaciones personales.

El riesgo colectivo: manipulación política e informativa

Cuando el cameo de IA se vuelve accesible a muchos, su uso político o social puede tener efectos devastadores. Un video falso de un líder diciendo algo incendiario, una figura pública “aprobando” una medida que nunca pronunció, puede viralizarse rápidamente y afectar elecciones, mercados o debates sociales.

La confianza en los medios y en lo que se ve con los ojos podría erosionarse ante la sospecha de que nada es “real”. Esa duda masiva es una forma de desestabilización: si la persona promedio no sabe qué creer, todo el sistema comunicativo colapsa.

Así las cosas, la legislación debe ponerse al día. Es urgente tipificar la creación maliciosa de contenido de imagen como un delito específico, con penas proporcionales.

Los derechos de imagen, de la personalidad, de la reputación deben extenderse al ámbito digital y prever sanciones claras contra el uso no autorizado. Los desarrolladores de IA deben incorporar “seguridad por diseño”: controles de consentimiento, limitaciones en el acceso a datos biométricos, y transparencia de modelo (quién tiene copia, quién puede usar tu cara).

Más que un cameo, un cruce de fronteras

El “cameo” de IA abre una nueva dimensión de lo digital: ya no basta con distinguir entre real y falso; ahora hay que ser una especie de guardián de nuestra propia representación. Un rostro o voz deja de ser algo que se tiene simplemente, para convertirse en un recurso que puede duplicarse, manipularse y reproducirse sin control.

Si nohay reacciona rápida, cada uno puede acabar siendo un cameo contra su voluntad: un avatar sin permiso, una voz que habla sin control, un video que acusa o trafica con la imagen. Lo que hoy parece un truco novelesco, podría mañana ser un arma contra tu identidad.

La defensa no sólo tecnología: es conciencia, regulación y cultura. Es menester exigir que toda IA que use su imagen lo haga con transparencia, trazabilidad y control absoluto. Porque si uno mismo no lo decide, es muy posible que alguien más lo haga por usted (sin su permiso)!