Hoy se celebra el Día Mundial de Concienciación sobre la Accesibilidad y para conmemorarlo Apple ha publicado una lista -impresionante- de nuevas funcionalidades de accesibilidad que llegarán a sus diferentes operativos en el segundo semestre del año y que buscan romper las barreras de entrada que muchas veces tiene la tecnología para que personas con alguna discapacidad puedan aprovecharla.

“Each year, we break new ground when it comes to accessibility. These new features will make an impact in the lives of a wide range of users, providing new ways to communicate, control their devices, and move through the world.” – Sarah Herrlinger, Apple’s senior director of Global Accessibility Policy and Initiatives.

Estas son algunas de las nuevas funcionalidades de accesibilidad que llegarán al iPhone y al iPad

Seguimiento Ocular

El seguimiento ocular ofrecerá a los usuarios una opción integrada de manera nativa en iOS y iPadOS para navegar en el iPad y el iPhone con solo sus ojos. Si bien no la hemos visto en funcionamiento, lo más lógico es que tome lo desarrollado por la compañía para visionOS que es, sin lugar a dudas, lo más mágico de las Vision Pro, para poder seleccionar objetos con sólo mirarlos.

La nueva funcionalidad de Eye Tracking utiliza la cámara frontal del dispositivo y algoritmos de machine learning para navegar a través de los elementos de una aplicación y activar cada elemento, accediendo a funciones adicionales como botones físicos, deslizamientos y otros gestos únicamente con sus ojos. Todo el procesamiento es realizado de forma segura en el dispositivo y no se comparten con Apple.

Music Haptics

Music Haptics es una nueva forma para que los usuarios sordos o con problemas de audición puedan experimentar la música en el iPhone. Con esta función de accesibilidad activada, el Taptic Engine en el iPhone reproduce toques, texturas y vibraciones refinadas en el audio de la música. Music Haptics funciona con millones de canciones en el catálogo de Apple Music, y estará disponible como una API para que los desarrolladores hagan que la música sea más accesible en sus aplicaciones.

Nuevas funcionalidades de Voz

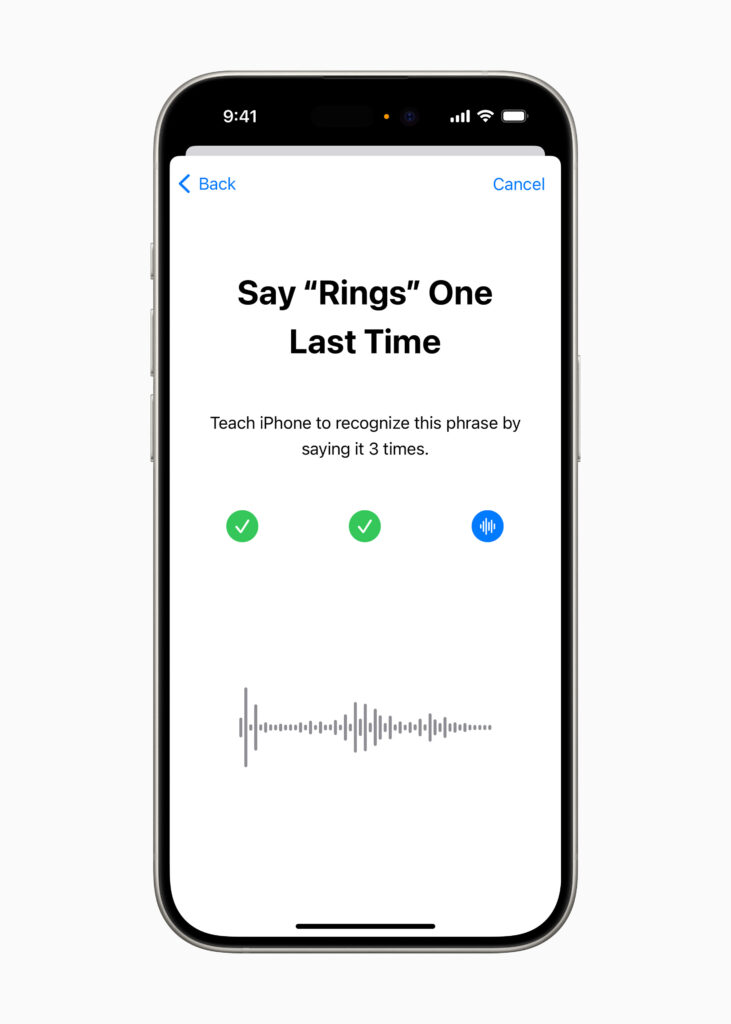

Atajos Vocales es una funcionalidad por medio de la cual los usuarios de iPhone y iPad pueden asignar expresiones personalizadas que Siri puede entender para lanzar accesos directos y completar tareas complejas.

Listen for Atypical Speech, otra nueva característica, ofrece a los usuarios una opción para mejorar el reconocimiento de voz para una gama más amplia de voz. Listen for Atypical Speech utiliza el aprendizaje automático en el dispositivo para reconocer los patrones de habla del usuario. Diseñadas para usuarios con afecciones adquiridas o progresivas que afectan al habla, como la parálisis cerebral, la esclerosis lateral amiotrófica (ELA) o el accidente cerebrovascular, estas características proporcionan un nuevo nivel de personalización y control, basándose en las características introducidas en iOS 17 para los usuarios que no hablan o corren el riesgo de perder su capacidad para hablar.

Vehicle Motion Cues

Para quienes nos mareamos fácilmente, la compañía está lanzando una nueva funcionalidad para el iPhone y el iPad llamada Vehicle Motion Cues que puede ayudar a reducir el mareo por movimiento de los pasajeros en vehículos en movimiento.

Por si usted no lo sabe, el mareo por movimiento es causado por un “conflicto sensorial” entre lo que una persona ve (y sus ojos le reportan al cerebro) y lo que siente (especialmente en el oido). Vehicle Motion Cues incluye unos puntos animados en los bordes de la pantalla que, utilizando varios sensores del iPhone (como los acelerómetros y giroscopios) pueden mostrar cambios en el movimiento del vehículo para ayudar a reducir el conflicto sensorial sin interferir con el contenido principal.

Esta nueva funcionalidad se podrá configurar para que se muestre automáticamente en el iPhone, o se podrá activar y desactivar en el Centro de Control.

Otras funcionalidades de accesibilidad que veremos con iOS 18 y iPadOS 18

Para los usuarios ciegos o con baja visión, VoiceOver incluirá nuevas voces, un rotor de voz flexible, control de volumen personalizado y la capacidad de personalizar los atajos de teclado de VoiceOver en Mac.

La lupa ofrecerá un nuevo modo de lectura y la opción de iniciar fácilmente el modo de detección con el botón Acción.

Los usuarios de Braille obtendrán una nueva forma de comenzar y permanecer en la entrada de pantalla Braille para un control y una edición de texto más rápidos; disponibilidad de japonés para la entrada de pantalla Braille; soporte para braille multilínea con Dot Pad; y la opción de elegir diferentes tablas de entrada y salida.

Para los usuarios con baja visión, Hover Typing mostrará un texto más grande al escribir en un campo de texto, y en la fuente y el color preferidos de un usuario.

Para los usuarios en riesgo de perder su capacidad para hablar, Personal Voice estará disponible en chino mandarín. Los usuarios que tengan dificultades para pronunciar o leer oraciones completas podrán crear una voz personal utilizando frases abreviadas.

Para los usuarios mudos, Live Speech incluirá categorías y compatibilidad simultánea con Live Captions.

Para los usuarios con discapacidades físicas, Virtual Trackpad for AssistiveTouch permite a los usuarios controlar su dispositivo utilizando una pequeña región de la pantalla como un trackpad redimensionable.

El control del interruptor incluirá la opción de usar las cámaras del iPhone y el iPad para reconocer los gestos de toque con el dedo como interruptores.

El control de voz ofrecerá soporte para vocabularios personalizados y palabras complejas.

Estas funcionalidades estarán disponibles con iOS 18 y iPadOS 18 cuyos betas serán lanzados la segunda semana de Junio en el WWDC 2024 y, lo más interesante, es que Apple ha utilizado el menú de accesibilidad no sólo para atender a usuarios con condiciones físicas o cognitivas sino para probar funcionalidades que luego terminarán implementándose de manera general (como el two finger tap del Apple Watch)