Apple y Google han emitido un comunicado conjunto en el que confirman los rumores y anuncian que han llegado a un acuerdo para que este último provea las bases para los modelos fundacionales de Apple Intelligence y Siri.

“Apple and Google have entered into a multi-year collaboration under which the next generation of Apple Foundation Models will be based on Google’s Gemini models and cloud technology. These models will help power future Apple Intelligence features, including a more personalized Siri coming this year. “

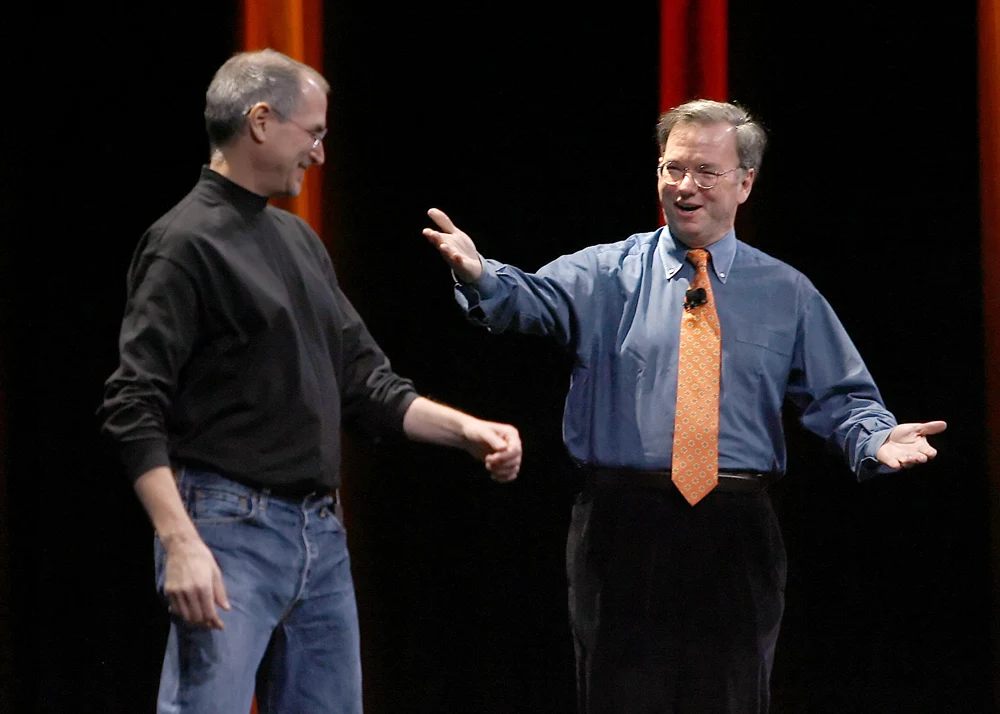

No es la primera vez que Apple utiliza servicios de Google para sus productos. A muchos se les olvida que Eric Schmidt, el CEO de Google, compartió tarima con Steve Jobs en el lanzamiento del iPhone original cuando la compañía anunció que tanto Google Search como Google Maps estarían presentes en el dispositivo.

¿Qué son los Modelos Fundacionales?

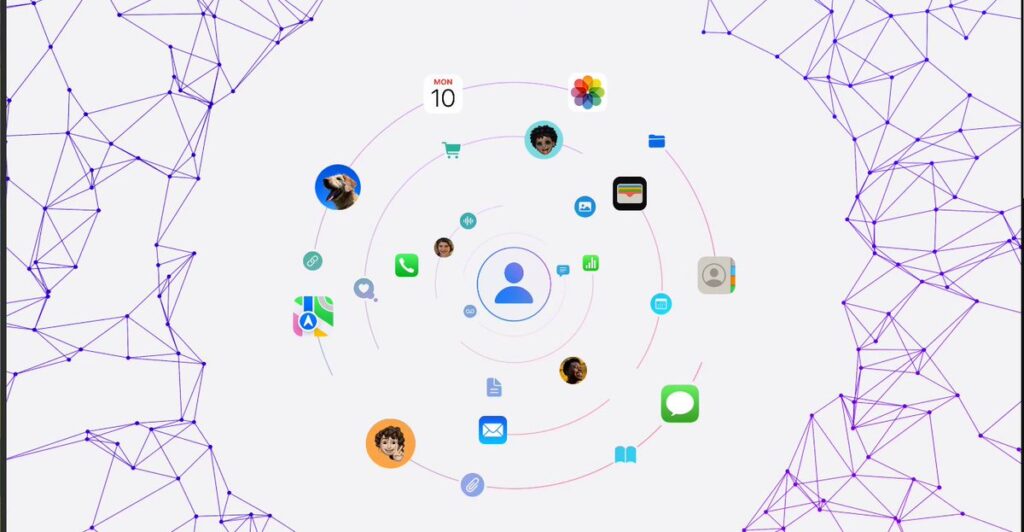

Cuando hablamos de Inteligencia Artificial (y nos enfocamos en lo que Apple ha indicado que quiere ofrecer a sus clientes) es importante entender las diferentes capas que hacen posible su funcionamiento.

Agentes Inteligentes

La Interfaz (un Chatbot)

El Modelo Fundacional

El Modelo Fundacional (o Modelo Base) es la capa inferior de la solución. Es el motor, el cerebro, la capa de conocimiento sobre el cual se ejecutan tanto los Chatbots como los Agentes Inteligentes. Son modelos que han sido entrenados de forma previa con una gran cantidad de datos, por medio de los cuales ha aprendido patrones y relaciones complejas que pueden transferir entre tareas y que, gracias a los recientes avances, les permiten no solo responder sino entender y razonar.

Gemini 3, por ejemplo, ha sido entrenado con 3 billones de parámetros de diversa naturaleza: texto, audio, video, números, tablas, links y documentos, convirtiéndose en uno de los modelos más efectivos para tareas multimodales.

La carrera de los modelos fundacionales ha sido extrema y costosa. Compañías como OpenAI, Microsoft, Meta, Anthropic, Baidu y Google, entre otros, han invertido miles de millones de dólares en su desarrollo y evolución. Apple no; Apple ha decidido tomar otro camino.

Un Camino Diferente

After careful evaluation, Apple determined that Google’s Al technology provides the most capable foundation for Apple Foundation Models and is excited about the innovative new experiences it will unlock for Apple users. Apple Intelligence will continue to run on Apple devices and Private Cloud Compute, while maintaining Apple’s industry-leading privacy standards.

Creo que es importante entender el acuerdo para no caer en errores.

Google proveerá la base tecnológica sobre la cual Apple desarrollará sus propios modelos fundacionales. Será una versión especifica de Gemini. Una versión que correrá exclusivamente en las infraestructura de Apple. En los motores neuronales de los chips de los iPhone, iPad y Mac y en la infraestructura dedicada de Private Cloud Compute que ha creado la compañía para esto y que crea unos estándares de privacidad que nadie más ofrece.

La compañía repite lo que hizo con Google Search, que sigue siendo el buscador defecto de Safari en todos sus dispositivos, para sobre ello construir el resto del stack.

¿Se acuerda de las otras 2 capas (la interfaz y los agentes inteligentes)? Esos seguirán siendo desarrollados por el equipo de Apple liderado por el recién contratado Amar Subramanya, quien (oh! qué coincidencia!) trabajó 16 años en Google, llegando a ser el jefe de ingeniería de Gemini.

Siri seguirá siendo Siri, pero tendrá un cerebro más potente, más versátil y más inteligente. Tanto Siri como Apple Intelligence seguirán usando componentes como el Semantic Index creado por Apple para almacenar y proteger su información personal, o Private Cloud Compute, la arquitectura diseñada por la compañía para asegurar el mayor nivel de privacidad posible en tareas asociadas con Inteligencia Artificial.

Y, gracias a las capacidades multimodales de Gemini, Siri podrá no sólo responder preguntas sino ejecutar tareas. ¿Tareas como cuáles? No sólo tareas como la de “Oye Siri, cierra las cortinas” (que hoy funcionan a la perfección con accesorios compatibles) sino tareas que implican el entender el contexto, el razonar y el orquestar acciones que involucran diferentes aplicaciones.

Déjeme le pongo un ejemplo: usted podrá decirle a Siri “A qué hora debo salir para recoger a mi mamá“. Utilizando el Semantic Index Siri validará quién es su mamá y barrerá sus correos o mensajes para encontrar uno en el que su mamá le haya indicado en qué vuelo viene.

Tomará esa información y alimentará en el Foundational Model para que Agente Inteligente valide la información del vuelo, su hora de llegada y el aeropuerto al que llega (seguramente utilizando un servicio de un tercero) y valide si el itinerario se está cumpliendo. La información será traída de nuevo a Siri que validará la distancia y las condiciones de tráfico entre usted y el aeropuerto y con ello creará un recordatorio para indicarle a qué hora debe salir.

Es un ejemplo sencillo y seguramente veremos aplicaciones más poderosas, pero creo que sirve para explicar la relación entre las 3 capas y el por qué, a pesar de usar a Gemini como base para sus modelos fundacionales, la experiencia de Apple Intelligence y de Siri seguirán siendo diferentes a las que ofrece el propio Google en Android.

Un Paralelo

Apple no produce sus pantallas. Se las compra a Samsung y a LG, quienes son los mejores fabricantes de pantallas. Pero no compra una pantalla genérica; les pide una pantalla con unas características especiales. Por eso, las pantallas del iPhone son diferentes de las demás smartphones. Aquí pasará lo mismo: Apple le pagará a Google por un modelo fundacional específicamente diseñado y entrenado bajo las especificaciones de Apple. Y los usuarios recibiremos lo mejor de los 2 mundos.