La inteligencia artificial (IA), en particular los modelos como los Generative Pre-trained Transformers (GPTs), está transformando la manera en que empresas y personas procesan información, toman decisiones y automatizan tareas. Sin embargo, junto con sus ventajas, estos avances tecnológicos también presentan riesgos significativos en términos de ciberseguridad. Entender estos desafíos es crucial para mitigar amenazas y aprovechar de manera responsable el potencial de la IA.

IA y ciberseguridad: La doble cara de los GPTs

1. Vulnerabilidades en la adopción masiva de la IA

Kaspersky señala que el 50% de las organizaciones ya han integrado IA en sus operaciones, mientras que un 33% planea hacerlo pronto. Este nivel de adopción masiva representa tanto una oportunidad como un riesgo. Los cibercriminales ven en estas tecnologías una nueva superficie de ataque, aprovechando vulnerabilidades en los modelos de IA para manipular datos, influir en decisiones empresariales e incluso comprometer la privacidad de los usuarios.

2. Amenazas comunes a los GPTs

- Ataques de envenenamiento de datos: Los atacantes introducen datos maliciosos en los modelos para alterar sus salidas, por ejemplo, haciendo que un GPT se desvíe de su modelo de negocios,

- Manipulación invisible: Los modelos pueden ser entrenados en datos sesgados sin que sus desarrolladores lo noten, generando respuestas incorrectas o discriminatorias.

- Filtración de información: Los sistemas GPT pueden memorizar datos sensibles y devolverlos en contextos inapropiados, comprometiendo la privacidad.

Impacto en sectores clave

1. Decisiones financieras y manipulación del mercado

Los GPTs están diseñados para procesar grandes cantidades de datos rápidamente. Sin embargo, esta capacidad puede ser explotada por cibercriminales para manipular tendencias de inversión, crear falsos movimientos de mercado o tomar decisiones erróneas que resulten en pérdidas millonarias.

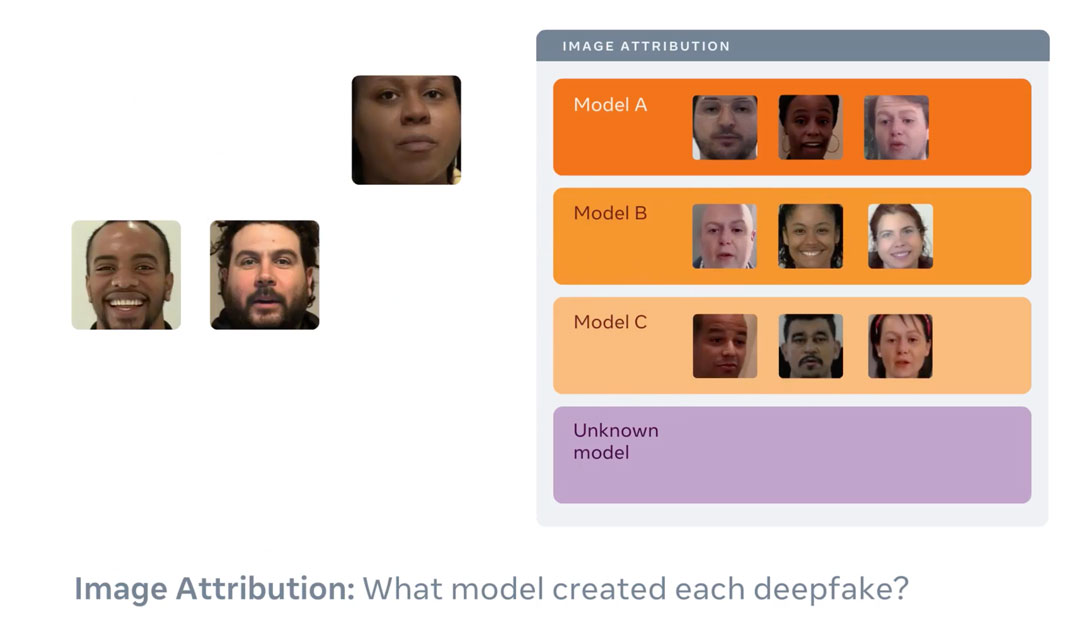

2. Desafíos éticos en la generación de contenido

- Deepfakes y desinformación: Los GPTs pueden crear contenido hiperrealista que desinforme a la población, afectando la confianza en medios y plataformas digitales.

- Falta de rendición de cuentas: La “caja negra” de la IA complica identificar responsabilidades cuando ocurren errores significativos.

Ejemplos reales de amenazas en IA

1. Fugas de datos sensibles

Empresas han cometido el error de compartir información confidencial con modelos de GPT sin tomar medidas adecuadas de seguridad. Esto ha llevado a la filtración accidental de datos sensibles.

2. Manipulación de respuestas generadas

En algunos casos, los atacantes han logrado influir en el comportamiento de los modelos para generar respuestas que desinforman o perjudican la reputación de terceros

Cómo abordar los riesgos de los GPTs

1. Implementación de buenas prácticas de seguridad

- Evaluaciones regulares: Las organizaciones deben realizar auditorías constantes de sus sistemas de IA para identificar posibles vulnerabilidades.

- Revisión de permisos: Es esencial limitar los datos que los GPTs pueden procesar para minimizar riesgos.

2. Educación para usuarios

- Concientización sobre ciberseguridad: Los usuarios deben entender cómo funcionan las IA y los posibles riesgos de compartir información con estas herramientas.

- Uso de tecnologías maduras: Optar por modelos desarrollados por empresas con experiencia comprobada en la implementación de medidas de seguridad.

3. Regulación y supervisión

Un enfoque colaborativo entre gobiernos, empresas y expertos es crucial para garantizar que las tecnologías de IA sean seguras, transparentes y responsables.

El equilibrio entre innovación y seguridad

Los GPTs representan una poderosa herramienta para el progreso, pero también abren la puerta a nuevos desafíos en ciberseguridad. En un entorno donde los ciberataques son cada vez más sofisticados, es fundamental que empresas, gobiernos y usuarios finales adopten un enfoque proactivo para proteger la integridad de los datos y garantizar un uso ético de estas tecnologías.