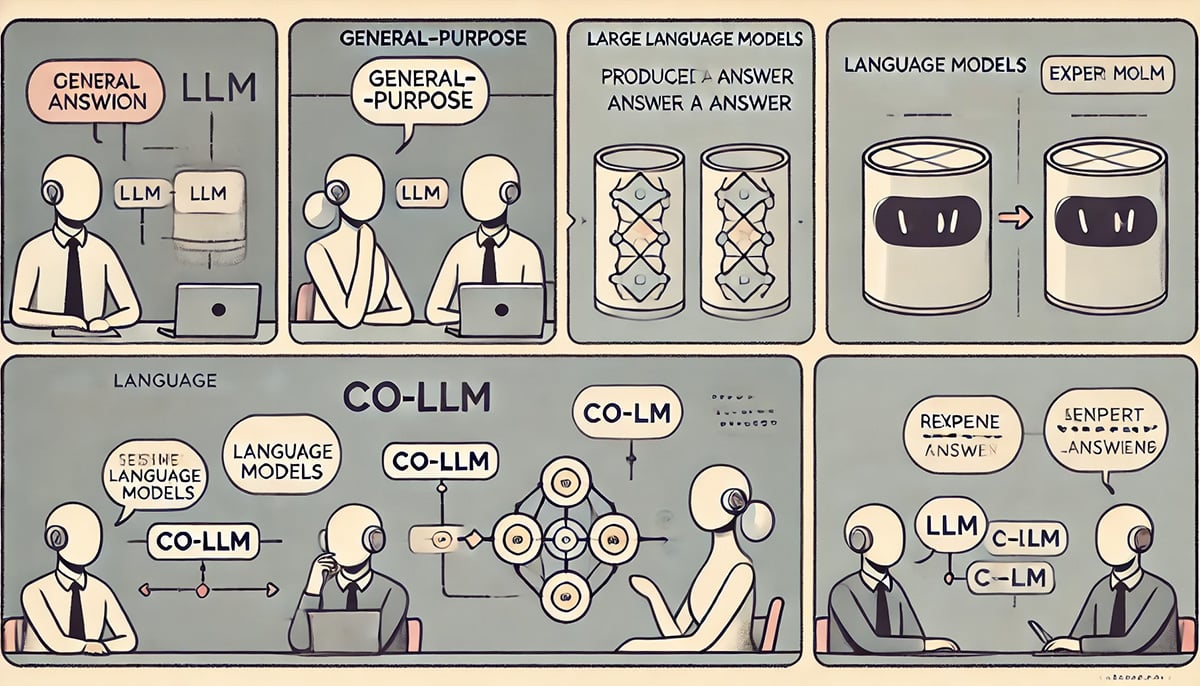

¿Alguna vez le han hecho una pregunta de la que solo sabía una parte de la respuesta? Para proporcionar una respuesta mucho más informada, lo más idóneo sería llamar a un amigo que tenga más conocimientos sobre el tema. Este proceso colaborativo también tiene la capacidad de poder ayudar a los grandes modelos lingüísticos (LLM) a mejorar su precisión. Aun así, ha sido difícil enseñarles a reconocer cuándo deberían colaborar con otro modelo para obtener una respuesta. En vez de utilizar fórmulas complejas o grandes cantidades de datos etiquetados para indicar en qué casos los modelos deberían trabajar juntos, los investigadores del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT han imaginado un enfoque más orgánico.

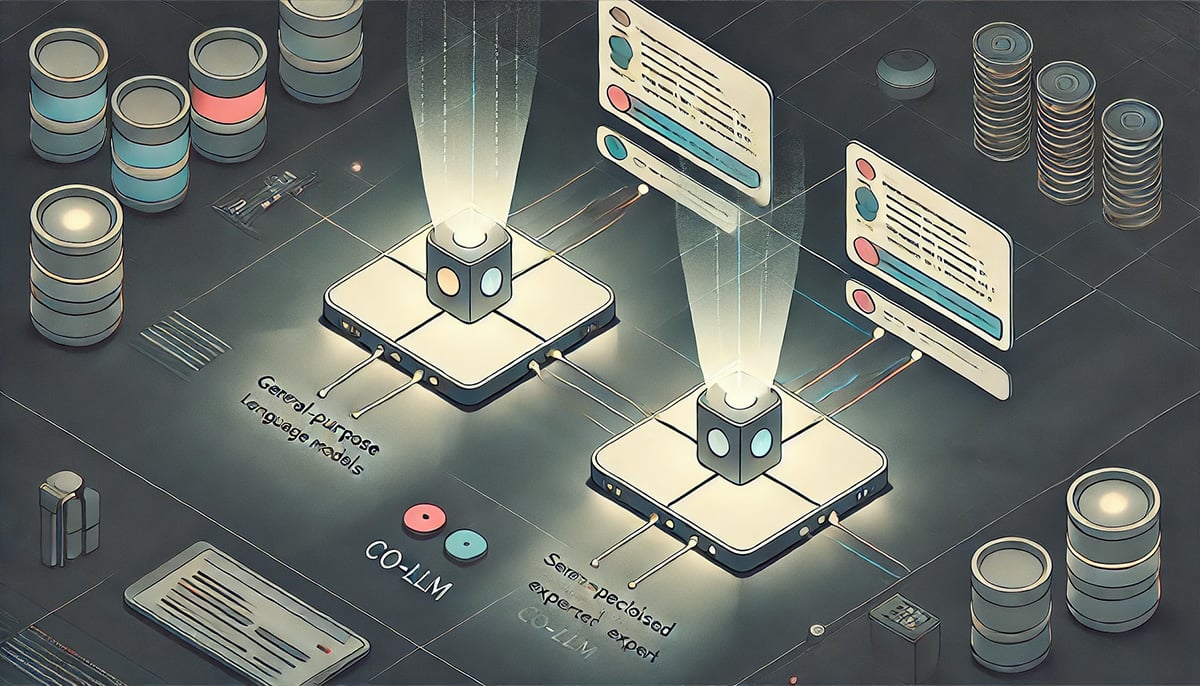

Su nuevo algoritmo, denominado “Co-LLM”, tiene la capacidad de poder emparejar un LLM base de propósito general con un modelo más especializado y ayudarlos a trabajar juntos. Mientras el primero elabora una respuesta, Co-LLM revisa cada palabra (o token) dentro de su respuesta para ver dónde puede recurrir a una respuesta más precisa del modelo experto. Este proceso conduce a respuestas mucho más precisas a cosas como indicaciones médicas y problemas de matemáticas y razonamiento. Dado que el modelo experto no es necesario en cada iteración, esto también transporta a una generación de respuestas más eficiente.

LLM: ¿No sabe la respuesta? Co-LLM le ayudará

Vale la pena destacar que, para decidir cuándo un modelo base necesita la ayuda de un modelo experto, el marco usa el aprendizaje automático para entrenar una “variable de cambio”, o una herramienta que puede indicar la competencia de cada palabra dentro de las respuestas de los dos LLM. El cambio es como un gerente de proyecto, que encuentra áreas en las que debería llamar a un especialista. Si le solicitara a Co-LLM que nombrara algunos ejemplos de especies de osos extintas, por ejemplo, dos modelos redactarían respuestas juntos. El LLM de propósito general comienza a armar una respuesta, con la variable switch interviniendo en las partes donde tiene la posibilidad de insertar un token mejor del modelo experto, como por ejemplo agregar el año en que se extinguió la especie de oso.

Puede imaginar que le pide a un LLM de uso general que nombre los ingredientes de un medicamento recetado específico. Puede responder incorrectamente debido a que, lo anterior, requiere la experiencia de un modelo especializado.

Para demostrar la flexibilidad de Co-LLM, los investigadores usaron datos como el conjunto médico BioASQ para combinar un LLM base con LLM expertos en diferentes dominios, como el modelo Meditron, que se encuentra entrenado previamente con datos médicos no etiquetados. Esto permitió que el algoritmo ayudara a responder las consultas que un experto biomédico recibiría regularmente, como nombrar los mecanismos que causan una enfermedad en particular.

Por ejemplo, si le solicita a un LLM simple solo que nombre los ingredientes de un medicamento recetado específico, puede responder incorrectamente. Con la experiencia adicional de un modelo que se especializa en datos biomédicos, obtendrá una respuesta mucho más precisa. Co-LLM también alerta a los usuarios sobre dónde verificar las respuestas.

Cuándo preguntarle al experto

El algoritmo de los investigadores del MIT subraya que imitar más fielmente el trabajo en equipo humano tiene la capacidad de aumentar la precisión en la colaboración entre varios LLM. Para aumentar todavía más su precisión factual, el equipo tiene la posibilidad de recurrir a la autocorrección humana: están considerando un enfoque de aplazamiento más sólido que tenga la capacidad de poder dar marcha atrás cuando el modelo experto no dé una respuesta correcta. Esta actualización permitiría a Co-LLM corregir el rumbo para que el algoritmo pueda seguir dando una respuesta satisfactoria.

Según informan, el equipo también quisiera actualizar el modelo experto (mediante el entrenamiento únicamente del modelo base) cuando haya nueva información disponible, manteniendo las respuestas lo más actualizadas posible. Esto permitiría a Co-LLM combinar la información más actualizada con un fuerte poder de razonamiento. Con el tiempo, el modelo podría ayudar con los documentos empresariales, usando la información más reciente que tiene para actualizarlos en consecuencia. Co-LLM del mismo modo podría entrenar modelos pequeños y privados para que funcionen con un LLM más potente para optimizar los documentos que deben permanecer dentro del servidor.