El enfoque del desarrollador de ChatGPT, OpenAI, para construir Inteligencia Artificial (IA) fue criticado esta semana por exempleados que acusan a la compañía de tomar riesgos innecesarios con tecnología que podría volverse dañina.

Hace un par de días, OpenAI publicó un nuevo artículo de investigación aparentemente destinado a demostrar que se toma en serio la lucha contra el riesgo de la IA haciendo que sus modelos sean más explicables. En el artículo, los investigadores de la compañía presentan una forma de observar el interior del modelo de Inteligencia Artificial que impulsa ChatGPT. Idean un método para identificar cómo el modelo almacena ciertos conceptos, incluidos aquellos que podrían causar que un sistema de IA se comporte mal.

Así funciona ChatGPT

Aunque la investigación hace más visible el trabajo de OpenAI para mantener la Inteligencia Artificial bajo control, también subraya la reciente agitación en la empresa. La nueva investigación fue llevada a cabo por el equipo de “superalineación” recientemente disuelto en OpenAI que se dedicaba a estudiar los riesgos a largo plazo de la tecnología.

Vale la pena señalar que, los codirectores del grupo anterior, Ilya Sutskever y Jan Leike, quienes abandonaron OpenAI, son nombrados coautores. Sutskever, cofundador de OpenAI y ex científico jefe, estuvo entre los miembros de la junta que votaron para despedir al director ejecutivo Sam Altman en el mes de noviembre pasado, lo que, como bien lo mencionamos desde TECHcetera, provocó unos días bastante caóticos que culminaron con el regreso de Sam Altman como líder.

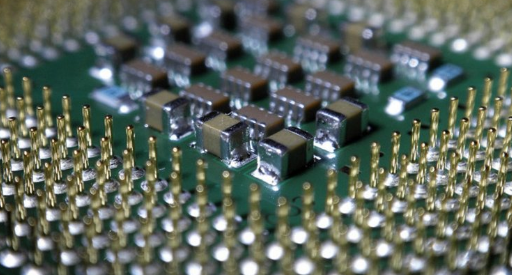

Ahora bien, ChatGPT de OpenAI funciona con una familia de modelos de lenguaje grandes denominados “GPT”, basados en un enfoque de aprendizaje automático conocido como redes neuronales artificiales. Estas redes matemáticas han logrado demostrar un gran poder para aprender tareas útiles mediante el análisis de datos de ejemplo, pero su funcionamiento no tiene la posibilidad de examinarse fácilmente como lo hacen los programas informáticos convencionales. La compleja interacción entre las capas de “neuronas” dentro de una red neuronal artificial hace que la ingeniería inversa sea un gran desafío para un sistema como ChatGPT con una respuesta particular.

“A diferencia de la mayoría de las creaciones humanas, realmente no entendemos el funcionamiento interno de las redes neuronales”, escribieron los investigadores detrás del trabajo en una publicación de blog adjunta.

Algunos destacados investigadores de Inteligencia Artificial (IA) creen que los modelos de IA más potentes, incluido ChatGPT, tal vez podrían usarse para diseñar armas químicas o biológicas y coordinar ciberataques. Una preocupación a largo plazo es que los modelos de Inteligencia Artificial tengan la capacidad de poder optar por ocultar información o actuar de forma dañina para lograr sus objetivos.

Artículo de OpenAI describe una técnica que reduce un poco el misterio…

El nuevo artículo de OpenAI describe una técnica que reduce un poco el misterio, al identificar patrones que representan conceptos concretos dentro de un sistema de aprendizaje automático con la ayuda de un modelo de aprendizaje automático adicional. Es de resaltar que, la innovación clave consiste en perfeccionar la red usada para mirar dentro del sistema de interés mediante la identificación de conceptos, para hacerlo mucho más eficiente.

OpenAI demostró el enfoque identificando patrones que representan conceptos dentro de GPT-4, uno de sus modelos de Inteligencia Artificial más grandes. La compañía lanzó un código relacionado con el trabajo de interpretabilidad, así como una herramienta de visualización que se tiene la posibilidad de usar para percibir cómo las palabras en diferentes oraciones activan conceptos, incluidas malas palabras y del mismo modo, contenido erótico, en GPT-4 y otro modelo.

Saber cómo un modelo representa ciertos conceptos podría ser un paso hacia la capacidad de reducir aquellos asociados con comportamientos no deseados, para mantener un sistema de IA en marcha. Igualmente podría permitir ajustar un sistema de Inteligencia Artificial para favorecer ciertos temas o ideas.

Hay que destacar que aunque los LLM desafían el interrogatorio fácil, un progresivo conjunto de investigaciones sugiere que se les puede pinchar y estimular de maneras que revelen información útil. Anthropic, un competidor de OpenAI respaldado por Amazon y Google, publicó el mes pasado un trabajo similar sobre la interpretabilidad de la Inteligencia Artificial. Para demostrar cómo se puede ajustar el comportamiento de los sistemas de IA, los investigadores de la compañía crearon un chatbot obsesionado con el puente Golden Gate de San Francisco. Y simplemente pedirle a un LLM que explique su razonamiento en ocasiones puede generar ideas.

“Es un progreso apasionante. Como campo, debemos aprender a comprender y examinar mucho mejor estos grandes modelos”, ha comentado David Bau, profesor de la Universidad Northeastern que trabaja en la explicabilidad de la IA, sobre la nueva investigación de OpenAI.

Bau ha señalado que la principal innovación del equipo OpenAI es mostrar una manera más eficiente de configurar una pequeña red neuronal que tiene la capacidad de poder usarse para comprender los componentes de una más grande. Pero, igualmente comenta que es necesario perfeccionar la técnica para hacerla más fiable.

Es de resaltar que, Bau es parte de un esfuerzo financiado por el gobierno de Estados Unidos llamado “National Deep Inference Fabric”, que pondrá recursos de computación en la nube a disposición de investigadores académicos para que ellos también puedan probar modelos de Inteligencia Artificial especialmente poderosos.

Ha afirmado, “Necesitamos descubrir cómo podemos permitir que los científicos realicen este trabajo incluso si no trabajan en estas grandes empresas”.

Los investigadores de OpenAI reconocen en su artículo que es imperioso seguir trabajando para optimizar su método, pero también señalan que esperan que conduzca a formas prácticas de controlar los modelos de Inteligencia Artificial.

“Esperamos que algún día la interpretabilidad pueda proporcionarnos nuevas formas de razonar sobre la seguridad y la solidez de los modelos, y aumentar significativamente nuestra confianza en potentes modelos de IA al brindar sólidas garantías sobre su comportamiento”, escriben.