Es crucial dar a conocer que investigadores desarrollaron una técnica de entrenamiento que reúne datos diversos para enseñar a los robots nuevas habilidades. ¿Hay una forma más rápida y eficiente de entrenar robots? A continuación conocerá todo al respecto.

Técnica para enseñar a los robots nuevas habilidades

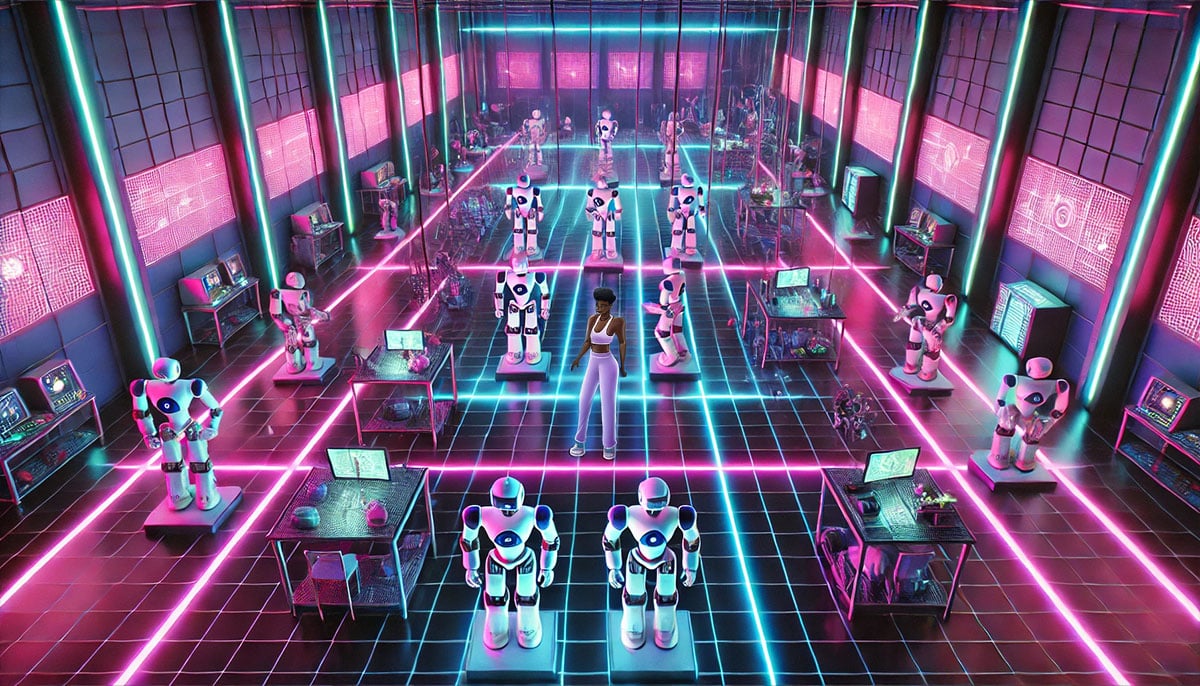

En la vida real, entrenar a un robot de uso general continúa siendo un gran desafío. Por lo general, los ingenieros recopilan datos específicos de un robot y una tarea determinados, que usan para entrenar al robot en un entorno controlado. Sin embargo, recopilar estos datos es costoso y lleva mucho tiempo, y así mismo, es posible que al robot le resulte difícil adaptarse a entornos o tareas que no haya visto antes.

Ante esto, para entrenar mejores robots de propósito general, los investigadores del MIT desarrollaron una técnica versátil que combina una monumental cantidad de datos heterogéneos de muchas fuentes en un sistema que tiene la capacidad de poder enseñar a cualquier robot una amplia gama de tareas.

Es de resaltar que, su método implica alinear datos de diversos dominios, como simulaciones y robots reales, y múltiples modalidades, incluidos sensores de visión y codificadores de posición de brazos robóticos, en un “lenguaje” compartido que un modelo de IA generativa tiene la capacidad de procesar.

Al combinar una cantidad tan enorme de datos, este enfoque se puede usar para entrenar a un robot para que lleve a cabo una variedad de tareas sin necesidad de comenzar a entrenarlo desde cero cada vez.

Vale la pena destacar que este método podría ser más rápido y, al mismo tiempo, menos costoso que las técnicas tradicionales porque requiere muchos menos datos específicos de la tarea. Además, superó al entrenamiento desde cero en más del 20% en simulaciones y experimentos del mundo real.

Entre los coautores de Wang se encuentran;el estudiante de posgrado de EECS Jialiang Zhao; Xinlei Chen, científico investigador de Meta y, así mismo, el autor principal Kaiming He, quien es profesor asociado de EECS y miembro del Laboratorio de Ciencias de la Computación e Inteligencia Artificial. Es de resaltar que la investigación se presentará en la Conferencia sobre sistemas de procesamiento de información neuronal.

Inspirado en los LLM

Una “política” robótica toma observaciones de sensores, como imágenes de cámara o mediciones propioceptivas que rastrean la velocidad y la posición de un brazo robótico, y luego le dice al robot cómo y dónde moverse.

Las políticas suelen entrenarse mediante aprendizaje por imitación, lo que significa que un humano demuestra acciones o teleopera un robot para generar datos, que se introducen en un modelo de Inteligencia Artificial (IA) que aprende la política. Debido a que este método usa una pequeña cantidad de datos específicos de la tarea, los robots suelen fallar cuando su entorno o tarea cambia.

Para desarrollar un mejor enfoque, Wang y sus colaboradores se inspiraron en grandes modelos de lenguaje como GPT-4 de OpenAI.

Estos modelos se entrenan previamente con una formidable cantidad de datos de diversos idiomas y luego se perfeccionan alimentándolos con una pequeña cantidad de datos concretos de la tarea. El entrenamiento previo con una cantidad tan grande de datos ayuda a los modelos a adaptarse para desempeñarse bien en una variedad de tareas.

Cabe aclarar que los datos robóticos adoptan muchas formas, desde imágenes de cámaras hasta inclusive, instrucciones en lenguaje natural y mapas de profundidad. Al mismo tiempo, cada robot es mecánicamente único, con una cantidad y orientación diferentes de brazos, pinzas y así mismo, sensores. Además, otro aspecto importante que señalar es que los entornos en los que se recopilan los datos varían ampliamente.

Los investigadores del MIT desarrollaron una nueva arquitectura denominada Transformadores Preentrenados Heterogéneos (HPT) que unifica datos de estas variadas modalidades y dominios.

Según se informa, colocaron un modelo de aprendizaje automático conocido como transformador en el centro de su arquitectura, que procesa las entradas de la visión y la propiocepción. Un transformador es el mismo tipo de modelo que forma la columna vertebral de los grandes modelos de lenguaje.

Los investigadores alinean los datos de la visión y la propiocepción en el mismo tipo de entrada, denominada token, que el transformador puede procesar. Cada entrada se representa con el mismo número fijo de tokens.

Posteriormente, el transformador asigna todas las entradas a un espacio compartido y crece hasta convertirse en un modelo enorme y preentrenado conforme procesa y aprende más datos. Cuanto más grande sea el transformador, mejor funcionará.

Un usuario solo requiere proporcionar a HPT una pequeña cantidad de datos sobre el diseño de su robot, su configuración y la tarea que desea que realice. Luego, HPT transfiere el conocimiento que el transformador ha adquirido durante el preentrenamiento para aprender la nueva tarea.

Permitiendo movimientos diestros

Ahora bien, uno de los mayores desafíos del desarrollo de HPT fue construir el conjunto de datos masivo para preentrenar el transformer, que incluía 52 conjuntos de datos con más de 200.000 trayectorias de robots en 4 categorías, incluidos videos de demostración humanos y simulación.

Los investigadores también necesitaban desarrollar una forma eficiente de convertir las señales de propiocepción brutas de un conjunto de sensores en datos que el transformador pudiera manejar.

Cuando probaron el HPT, el rendimiento del robot mejoró en más del 20% en tareas de simulación y del mundo real, en comparación con el entrenamiento desde cero cada vez. Incluso cuando la tarea era muy diferente de los datos previos al entrenamiento, el HPT siguió mejorando el rendimiento.

En el futuro, los investigadores quieren estudiar cómo la diversidad de datos podría mejorar el rendimiento de HPT. Del mismo modo, quieren mejorar HPT para que pueda procesar datos no etiquetados como GPT-4 y otros modelos de lenguaje de gran tamaño.